为什么“免费午餐”这种事情有点存在

关于神经科学和人工智能中模式的普适性

“没有免费的午餐。”- 罗伯特·A·海因莱因

在机器学习领域,“没有免费的午餐”定理让我想起了哥德尔的不完备定理。

虽然这些定理经常被引用,但很少有人深入解释,实际应用的影响也常常不明确。就像哥德尔的定理成为20世纪初数学家信仰完整和自洽的形式系统的一种威胁一样,“没有免费的午餐”定理挑战了我们对于通用机器学习算法效力的信仰。然而,这些定理对于日常实际应用的影响通常很小,大多数从业人员在这些理论约束下继续前行。

在本文中,我想探讨“没有免费午餐”定理的内容,并深入研究它与视觉、迁移学习、神经科学和人工通用智能的关联。

“没有免费午餐”定理,由沃尔珀特和麦克雷迪于1997年提出,通常用于机器学习的上下文中,它指出没有一个算法是普遍适用于所有可能的问题的最佳算法。没有神奇的一刀切解决方案。一个算法可能在一个任务上表现得非常好,但在另一个任务上可能表现不佳。

机器学习的一个基本目标是辨别不同数据中的有意义的模式。然而,算法的有效性通常取决于手头数据的具体性质。它可能对一种类型的数据非常有效,但在应用到另一种类型的数据时效果可能较差。

当考虑到我们可能遇到的不同类型的数据时,这一点变得显而易见。一个简单的抛硬币产生了一个简单的概率分布的两种模式。

另一方面,实际上更重要的例子,比如图像数据或文本数据,要复杂得多。随着像素数量的增加,潜在模式的宇宙数量呈指数级增长,使得一个500×500像素图像的可能配置数组已经难以想象地大:

鉴于此空间的规模,我们如何从数据中学到有意义的东西呢?

答案中的一个重要部分是,大多数感兴趣的样本不是从所有可能样本的空间均匀采样的,而是与随机采样相比具有大量的预先存在的结构。

语言数据是另一个经典的例子。任何一种给定语言的所有单词总和都由一组模式组成,这些模式存在于比字母的所有可能组合要低得多的低维空间中,这是最初简单的语言统计模型所使用的(我在我的马尔科夫链文章中更深入地探讨了这一点)。

对于机器学习者来说,许多类型的输入数据中都存在一些重复的模式,这是个好消息。这意味着我们可以训练模型来学习提取这些模式,甚至可能重复使用模型在不同的应用程序中提取相似的模式。

迁移学习技术明确利用了大多数现实世界问题共享一些共同结构的事实。

迁移学习使用预训练模型,这些模型已经从大型数据集中学习到了模式,以适应和“微调”不同但相关的任务。一个训练用于识别图像中的对象的模型可能已经学习到了低级特征,如边缘和颜色梯度,以及高级特征,如形状。这些学习到的特征可以应用于相关任务,例如识别手写数字或分类医学图像中的肿瘤。

Hubel和Wiesel在发现视觉皮层由层次结构组成,处理越来越复杂的模式时就发现了这一点,他们因此获得了1981年的诺贝尔奖。自从卷积神经网络(CNNs)的出现以来,他们的工作已经广泛地在与机器学习算法相关的讨论中被提及。

比如,在视觉皮层中,简单细胞可以检测边缘和颜色的梯度,而复杂细胞将这些简单细胞的输出聚合起来识别更广泛的模式,如运动或特定形状。深入视觉系统,神经元识别的模式变得越来越复杂,从简单的几何形状到面孔和复杂的物体,最终到只有在看到你的奶奶(或者在你尝到她小时候给你做的玛德琳蛋糕时)才会触发的(臭名昭著的)奶奶神经元。

同样地,CNN的层次提取越来越复杂的特征。在初始层中,CNN可能学习检测简单的结构,如线条、角度和颜色斑点。随着我们逐层深入,这些简单的特征结合起来形成更复杂的表示:圆圈、矩形,最终形成看起来像猫、狗或大象的可辨识物体。

也许这些相似之处并不令人惊讶:两个系统都已经进化和被设计,分别用于利用视觉数据中固有的结构。这种对各种视觉场景中最常见的模式的理解可以被重新利用或转移到处理不同但相关的任务中,就像之前讨论的那样。

这就是迁移学习和大脑适应和学习能力的概念发挥作用的地方。学习认识自行车的孩子在学习认识摩托车时并不是从头开始。他们把对自行车基本结构的理解从一个背景转移到另一个背景。同样,一个在各种图像上训练过的CNN在从识别面孔切换到识别手写数字时不需要重新学习“边缘”的概念。

我们自己的大脑已经发现了与机器学习中“免费午餐”的基础相同的真理:对我们有用的世界远非均匀随机,而是充满了重复出现的模式和结构。鉴于这些模式是我们感兴趣的,我们的大脑被硬性编程为有选择地感知它们。

我们甚至可以比简单地说,我们很幸运世界上有有意义的模式。现代认知神经科学理论将大脑看作是一个“预测机器”,而不是一个“现实”感知工具。

例如,贝叶斯大脑假说表明,我们的大脑不断地对世界进行概率预测,并根据感官输入更新这些预测。因此,我们对世界的感知不是被动的过程,而是主动的过程。我们不仅仅是看到世界的本来面目,而是根据我们的先验知识主动地进行解释,其中一些基于我们记忆中的经验,但有些则追溯到亿万年的演化过程中诱导的结构先验。

认知的主动、先验驱动成分对我们的感知有如此重要的影响,以至于Anil Seth等科学家将我们的大脑活动称为类似于“受控幻觉”。

这也与唐纳德·霍夫曼(反对现实的案例)的引人注目的想法相联系,即我们不是感知现实本身,而是经过数百万年的发展成为“用户界面”的现实,并且其主要目标是帮助我们生存。例如,你电脑桌面上的图标并不揭示机器内部正在发生的真实情况,而是提供一个界面,使你可以轻松使用电脑。

例如,我们所感知的红色苹果并不是苹果本身,而是一个引导我们寻找营养食物的表示。因此,我们的知觉系统对感官输入施加了强烈的先验,过滤掉了大量不符合我们预先存在的模型或不直接对我们的生存有贡献的数据。这种偏向显著模式而远离感知噪声(由我上面显示的所有可能视觉模式组成的噪声图像集)的偏见,呼应了我们一直讨论的迁移学习和机器学习中的“免费午餐”的结构。

我们的大脑就像预训练模型一样,只学习关注世界上的某些模式,帮助我们应对不断涌现的新感官输入。

我们越老,就越不可能倒转我们的模型并在遇到新模式时进行微调,我们在脑中走来走去的推理机就是自由午餐的典范:老白男人就是一个通过他已经坚定建立的世界模型的镜头来解释他遇到的一切的人,而这种模型在他的脑海中是通用的算法,可以让他在遇到任何学习问题时轻松获得自由午餐。

开玩笑的,虽然模态之间的迁移学习至关重要,但我们的讨论也很好地延伸到了当前的多模态设置中,包括神经科学和机器学习。

大脑具有惊人的自我重组能力,称为神经可塑性,这种能力常常在中风或其他严重感官损失的情况下观察到。

感官损失通常导致某些脑区的重新定位。例如,盲人通常会发展出更加敏锐的听觉和触觉。这不仅仅是因为注意力和练习增加了,研究表明,视觉皮层,通常处理视觉信息,在盲人中在听觉和触觉任务中变得活跃(David Eagleman的书《Livewired》对神经可塑性在大脑中的核心作用给出了一个非常好的解释)。

这就好像大脑拿着一个预先训练过的视觉任务的神经网络,发现自己不再接收视觉输入,就微调它来处理听觉和触觉信息。

同样,聋人在使用手语时被发现使用了通常与处理口语的区域,如布罗卡(Broca)区和沃尼克(Wernicke)区。这些区域专门用于交流,无论交流的具体形式如何,大脑的语言网络都足够灵活,可以处理不同形式的交流,无论是口头、书面还是手语。

这些神经可塑性的例子向我们展示了,我们的大脑计算是由一种通用的学习算法支撑的,能够处理广泛的模式,而不仅仅是与特定感官模态相关的模式。这个算法的精确基础是有争议的(例如,Jeff Hawkin的《千个大脑》或Kurzweil的模式识别器提供了流行的神经科学解释,而Pedro Domingues的《主算法》提供了计算机科学的视角),但神经可塑性清楚地表明了这种算法的存在。

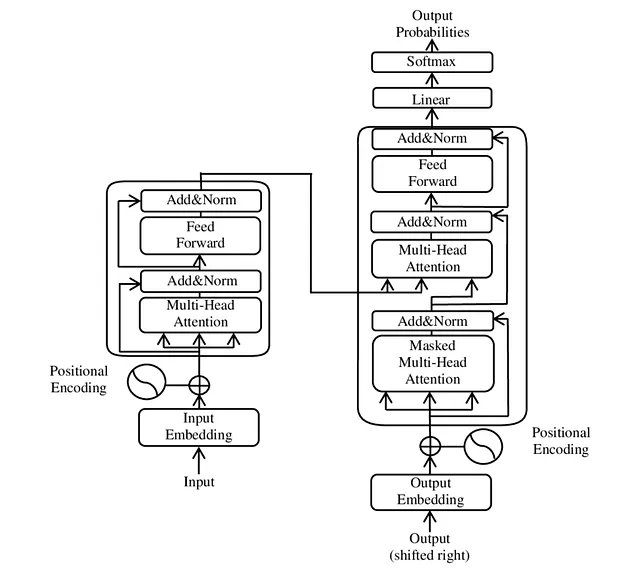

大脑的多功能性也反映在我们最先进的机器学习模型中。虽然Transformers最初是为自然语言处理而开发的,但它们已经被应用于各种数据类型,从图像和音频到时间序列数据(是否主要是因为它们目前很受欢迎可以争论不休)。就像盲人的视觉皮层可以重新定位为听觉或触觉任务一样,Transformers可以适应各种数据类型,表明这些模型可以捕捉到通用模式,无论具体的输入模态如何(公正地说,这可能部分是因为Transformers非常适合在我们当前的计算架构中进行优化,因为它们可以被大量并行化)。

引用Wolpert和Macready的原始NFL论文:“在所有可能的问题上平均它们的表现时,任何两个优化算法都是相等的。” 但是用奥威尔的话说,当我们看到大多数真正关心我们的问题时,有些优化算法比其他算法更加平等。

例如,将Transformer应用于图像数据已经产生了诸如Vision Transformers之类的模型,这些模型将图像视为一系列补丁,并应用相同的自我注意机制。

这个想法在多模态Transformer中得到了进一步的体现,它可以同时处理和理解多种类型的数据。文本和图像嵌入模型(如CLIP模型)通过同时训练来理解图像和相关文本描述。CLIP通过将两种模态融合到一个联合嵌入空间中来学习它们之间的关系。

这种模型利用了不同数据类型之间的共同结构,有效地创建了它们之间的“翻译”系统。CLIP这种能力的一个惊人示例,现在对我们大多数人来说已经很熟悉了:通过为像DALL-E这样的扩散模型提供基础,它们允许我们仅通过文本描述生成令人印象深刻的图片。

这种方法如此成功的原因也可能并非完全是巧合的:语言中最有意义的单元(例如“猫”、“狗”或“爱”)很短,而且语言结构沿着在视觉场景中对我们有重要意义的相同概念来构建:互联网上很可能会有更多的猫的图片,而不是嘈杂的色块。更一般地说,需要注意的是,语言已经是一种派生模态,是大量人共同发展出来将最重要的事情压缩成简洁的符号表示的模态。

或许最深刻的是,“免费午餐”的事实也与人工通用智能(AGI)有关,因为AGI是一种算法,能够从大多数应用中获得免费午餐。

想想Chat-GPT:虽然GPT模型完全是在文本上进行训练的,但它们开始展现出理解、推理和交流整个世界的能力,远远超出了文本数据的限制。尽管只接受文本数据的预测训练,但这些模型似乎揭示了一种超越文本的普遍逻辑,扩展到不同的模态和理解维度。

特别是当与其他模式共同训练时,LLM已经超越了该模式的文本描述,而是理解了跨模式的基本模式,并可以从中生成新的想法,类似于大脑。

我认为人们(包括我自己)对LLM在实现普遍智能方面取得成功的原因感到惊讶,其中一个原因是我们共同低估了最引人注目的知觉世界已经依赖于模式的普适性以及我们大脑中的学习算法的普适性的程度。

虽然免费午餐定理在理论上是正确的,但很显然,大多数我们最关心的问题在统计意义上远非普遍。它们往往占据一个低维空间,主要涉及视觉、语言和声音,这是人类兴趣和显著性的主要领域。

在多模态大型语言模型的出现中,我们有了一个算法框架,它能够利用这些低维和跨模态的表示。它为AGI的潜力提供了一个令人兴奋和略带恐惧的预览,以及它如何改变我们的世界和我们对世界的理解。