斯坦福研究人员推出SequenceMatch:使用模仿学习损失训练LLMs

自回归模型是一类基于变量当前值高度依赖于其过去值的统计模型。换句话说,该模型通过将变量回归其过去值来预测变量的未来值。自回归模型最著名的例子之一是GPT模型,特别是GPT-3及其变种,它们主要基于给定以前单词的情况下预测序列中下一个单词的基础上。通过在大型文本语料库上以这种自回归方式训练GPT,它学会了捕捉语言中的统计模式、依赖关系和语义关系,从而使其能够根据输入提示生成上下文相关的文本。然而,先前的研究实验证明,较小的模型或调整为具有较少随机性或变异性(即,较低的生成温度)的模型往往会生成重复或错误的输出。此外,在某些情况下,这些模型会使用自己的输出作为输入,常常导致不断增加的错误,迅速使模型超出其预期的分布范围。

为了克服这些挑战,来自斯坦福大学的研究人员进行了初步研究,并确定了两个主要障碍,阻止了使用最大似然估计(MLE)训练的自回归模型在评估过程中生成连贯序列。第一个问题在于用于评估模型和数据分布之间差异的离散度量。由于MLE不考虑分布之外的(OOD)序列,因此无法控制模型在此类序列上的行为。为了解决这个问题,研究人员提出了一种新的方法,即最小化实际数据和自回归生成序列之间的χ2离散度,这种方法相对于MLE表现出更好的性能。第二个挑战在于,当模型产生一个没有适当延续与数据分布相一致的OOD标记时。为了解决这个问题,研究人员在生成过程中引入了一个<backspace>操作,允许模型擦除前一个标记并纠正任何可能出现的错误。

通过从初步研究中得出这些经验教训,斯坦福研究人员提出了一种新方法SequenceMatch,该方法使自回归模型针对差异技术进行训练,同时添加了一个<backspace>操作,允许模型纠正错误。研究人员将序列生成问题重构为强化学习问题,简单地说,可以总结为从给定状态(即部分序列)的所有可能序列中选择下一步行动(在这种情况下,即生成下一个标记)。因此,通过利用强化学习领域内的非对抗性模仿学习的最新发展,研究人员能够减少训练模型的占用度度量和实际数据分布之间的差异。此外,为了进一步减小序列生成中的复合误差,自回归模型使用<backspace>操作进行训练,而不是MLE,以便通过允许模型删除标记来实现回溯。这种完全监督的语言模型损失技术SequenceMatch可以用作微调预训练模型的额外步骤。

- 如何使用TensorFlow构建负责任的人工智能?

- 来自 Meta AI 和 Samsung 的研究人员介绍了两种新的 AI 方法,Prodigy 和 Resetting,用于学习速率适应,这些方法改进了现有最先进的 D-适应方法的适应速率

- 理解贝叶斯市场营销组合建模:先验规范的深入研究

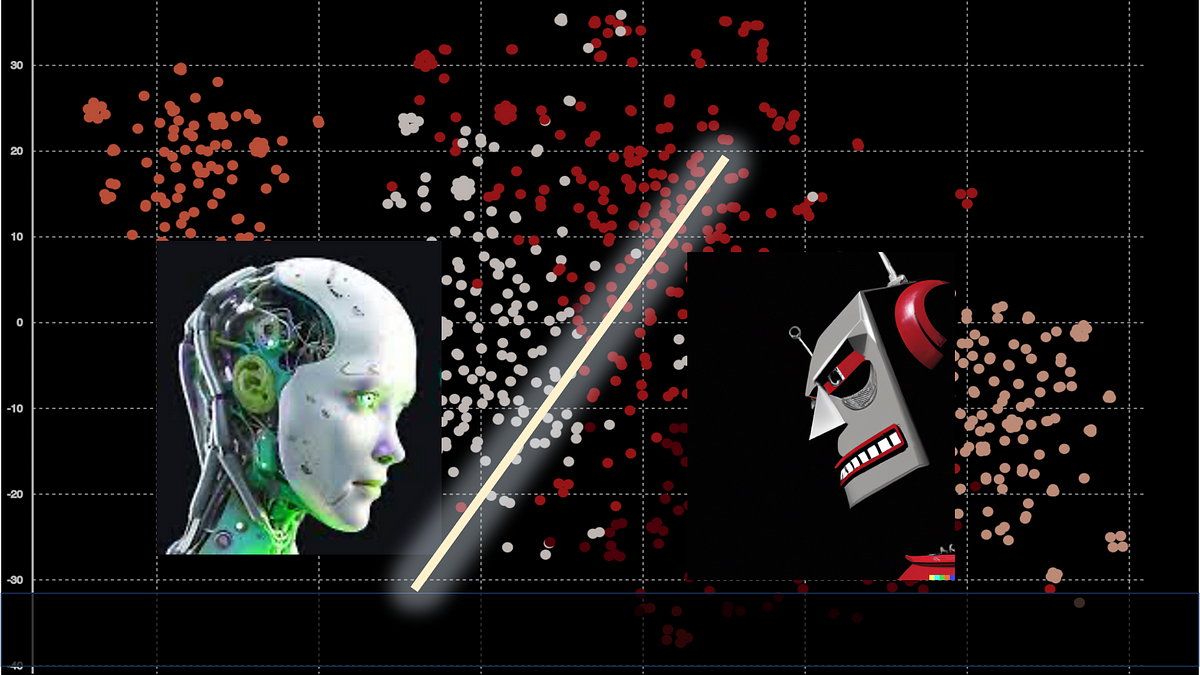

研究人员进行了几次实验评估,以比较在SequenceMatch上微调的基于GPT-2的模型与经过MLE训练的模型的性能。研究人员使用MAUVE分数作为指标来比较性能,结果表明,在SequenceMatch上微调的模型生成的文本更接近数据集,并且在与经过MLE训练的模型比较时,更流畅、更无错误。团队还强调了其模型的局限性,即生成长文本需要更多的计算资源和时间。在未来的工作中,研究人员将重点研究不同的离散方法如何影响生成序列的质量。