从GPT-3到未来的语言模型

介绍

大型语言模型(LLMs)已经彻底改变了自然语言处理,使得计算机能够以前所未有的准确性生成类人文本和理解上下文。在本文中,我们将讨论语言模型的未来是什么?LLMs将如何改变世界?在众多值得注意的LLMs中,生成式预训练转换器3(GPT-3)作为一个重要的里程碑,以其惊人的语言生成能力吸引了全世界的眼球。然而,随着LLMs的不断发展,研究人员一直在解决GPT-3的局限性和挑战,为未来更强大的语言模型铺平道路。

在这里,我们将探讨LLMs的演变,从GPT-3开始,深入到语言建模领域中即将到来的进步、实际应用和令人兴奋的可能性。

学习目标

- 了解各种类型的LLMs。

- 了解GPT3及其基础模型。

- 了解LLMs的进展。

- 学习如何使用Hugging Face的LLM权重以及什么是微调。

本文是数据科学博客马拉松的一部分。

不同类型的LLMs

1. 基础LLMs

基础LLMs作为基础的预训练语言模型,是各种自然语言处理(NLP)任务的起点。它基于文本训练数据预测下一个单词。

- 来自微软和加州大学圣塔芭芭拉分校的研究人员提出了LONGMEM:一种人工智能框架,使LLMs能够记忆长期历史

- 使用Docker调试SageMaker终端节点

- 相似度搜索,第四部分:分层可导航小世界(HNSW)

应用

- 文本生成:LLMs在生成连贯和上下文相关的文本方面非常出色,使它们在内容创作、创意写作辅助和自动化摘要方面非常有用。

- 问答:LLMs可以阅读和理解文本文档,使它们能够根据提供的信息回答问题。

- 机器翻译:LLMs可以提高机器翻译系统的准确性和流畅性,促进不同语言之间的文本翻译。

2. 指令调整LLMs

指令调整LLMs是指针对特定任务或指令进行微调或专业化的语言模型,旨在符合这些特定指令。

基础LLMs提供了对语言的广泛理解,而指令调整LLMs则是专门训练以遵守特定指南或指令,使其更适合特定应用。

应用

- 机器翻译:可以针对特定的语言对或领域对LLMs进行微调,以提高翻译质量和准确性。

- 情感分析:可以通过在训练过程中提供特定的指令或示例,将指令调整LLMs微调以更准确地执行情感分析。

- 命名实体识别:可以将指令调整LLMs微调以更精确地识别命名实体(例如人物、组织、地点)。

- 意图识别:可以将指令调整LLMs微调以准确地识别和理解应用程序中的用户意图,例如语音助手或聊天机器人。

基础LLMs和指令调整LLMs在语言模型的发展和NLP应用中都起着至关重要的作用。基础LLMs通过其对语言的普遍理解提供了坚实的基础,而指令调整LLMs则提供了一定程度的定制和特定性,以满足特定任务或指令的要求。

通过使用特定的指令、提示或领域特定数据微调LLMs,指令调整LLMs可以提供更强大的性能和更好的与特定任务或领域的对齐性,相比基础LLMs。

GPT-3:LLM发展的里程碑

生成式预训练转换器3(GPT-3)已经成为大型语言模型(LLMs)领域的一项重大成就。这个革命性的模型因其优异的语言生成能力引起了广泛的关注,并推动了自然语言处理领域先前认为不可能的边界。

GPT 3基础模型

GPT-3模型具有理解和生成自然语言的能力。 GPT 3基础模型是仅可用于微调的模型。

它的端点为:/v1/completions

使用GPT3 Davinci模型进行文本生成

首先要做的任务是将您的OpenAI API密钥加载到环境变量中并导入必要的库。

# 导入必要的库

import openai

import os

import IPython

from dotenv import load_dotenv

load_dotenv()

# API配置

openai.api_key = os.getenv("OPENAI_API_KEY")这演示了如何使用OpenAI的GPT-3模型(这里是davinci模型)生成文本。提示用作起点,使用“openai.Completion.create()”方法向GPT-3发出API调用以生成文本。然后将生成的文本打印到控制台,让用户可以查看文本生成过程的输出。

# 为文本生成定义提示

prompt = "从前有一个人"

# 使用GPT-3生成文本

response = openai.Completion.create(

engine='davinci',

prompt=prompt,

max_tokens=100 # 调整所生成文本的长度

)

# 打印生成的文本

print(response.choices[0].text.strip())输出

我曾经担任卫生服务协调员,面临着创建一个体重图表以分发给我们的客户的繁重任务。 它有7个类别,加上一个标题。 这是一个挑战。

尽管有GPT3,但仍需要其他LLMs

尽管GPT-3是强大而多才多艺的语言模型,但仍需要其他LLMs来补充和增强GPT-3的能力。以下是一些其他LLMs重要的原因:

- GPT-3是一个通用语言模型,但专业LLMs可以为特定用例提供更好的性能和准确性

- 更小更高效的LLMs为计算成本昂贵的GPT-3提供了一种经济实惠的替代方案,使部署更加可行。

- 在特定数据集上训练的LLMs或融合特定领域知识的LLMs在专业领域中提供上下文理解和更准确的结果。

- LLMs领域持续的研究和发展有助于推进自然语言处理的发展。

尽管GPT-3是一个出色的语言模型,但开发和利用其他LLMs是必要的,以迎合专业领域,提高效率,融合特定领域的知识,解决伦理问题,并推动自然语言处理领域的进一步研究和创新。

LLM的进步超越GPT-3

LLMs的进化不止于GPT-3。 研究人员和开发人员不断致力于解决限制和挑战。 最近的模型,例如GPT-4,Megatron,StableLM,MPT等,都建立在GPT-3奠定的基础之上,旨在提高性能,效率和偏见处理能力。

例如,

- GPT-4专注于减少计算要求,同时保持或提高语言生成的质量。

- Megatron强调可扩展的模型训练,使得即使更大的LLMs也可以高效地进行训练。

- StableLM针对大型模型的稳定性问题,确保了一致和可靠的性能。

这些先进的LLM已经展现出了前景。例如,Megatron在各种NLP基准测试中取得了最先进的结果。StableLM解决了与灾难性遗忘相关的问题,使得大规模模型可以进行持续学习。这些进步为更高效、能力更强、更可靠的LLM铺平了道路,可以在更广泛的应用中部署。

2023年最近LLM的发展

商业用途中LLM的问题在于它们可能不是开源的或被禁止使用。因此,企业可能根本无法使用它们,或者可能不得不支付费用。出于透明度和更改代码的灵活性等原因,一些企业也可能更喜欢使用开源模型。

商业可用的开源语言模型

有许多商业可用的开源语言模型。

- Pythia : 其中包含两组大小为70M、160M、410M、1B、1.4B、2.8B、6.9B和12B的8个模型。每个模型大小的检查点都在拥抱面上可用。您也可以在GitHub上查看实现。

- StableLM Alpha : StableLM-Tuned-Alpha是一个基于StableLM-Base-Alpha模型构建的3B和7B参数解码器-only语言模型的集合,并在各种聊天和指令遵循数据集上进一步微调。两种模型大小的检查点都在拥抱面上可用。您也可以在GitHub上查看实现。

- H2oGPT : h2oGPT是一个针对大型语言模型(LLMs)的微调框架,以及具有文档问题-答案能力的聊天机器人UI。文档提供与指令相关的上下文,有助于将LLMs与幻觉接地。您可以在GitHub上查看实现。

- Dolly : Dolly-v2-12b是在Databricks机器学习平台上训练的指令-following large language模型。它不是最先进的模型,但展示了与其构建所基于的基础模型不典型的高质量指令遵循行为。您可以在GitHub上查看实现。

- Bloom : BLOOM是在大量文本数据上训练的自回归大型语言模型(LLM)。因此,它可以生成46种语言和13种编程语言的有意义的文本,几乎无法与人类编写的材料区分开。您可以在Hugging Face上检查Bloom的检查点。

- Falcon : Falcon-40B是一个40B参数的因果解码器-only模型。它胜过了LLaMA、StableLM、RedPajama、MPT和许多其他模型。它是一个预训练模型,应该进一步微调大多数用例。您可以在Hugging Face上查看模型。

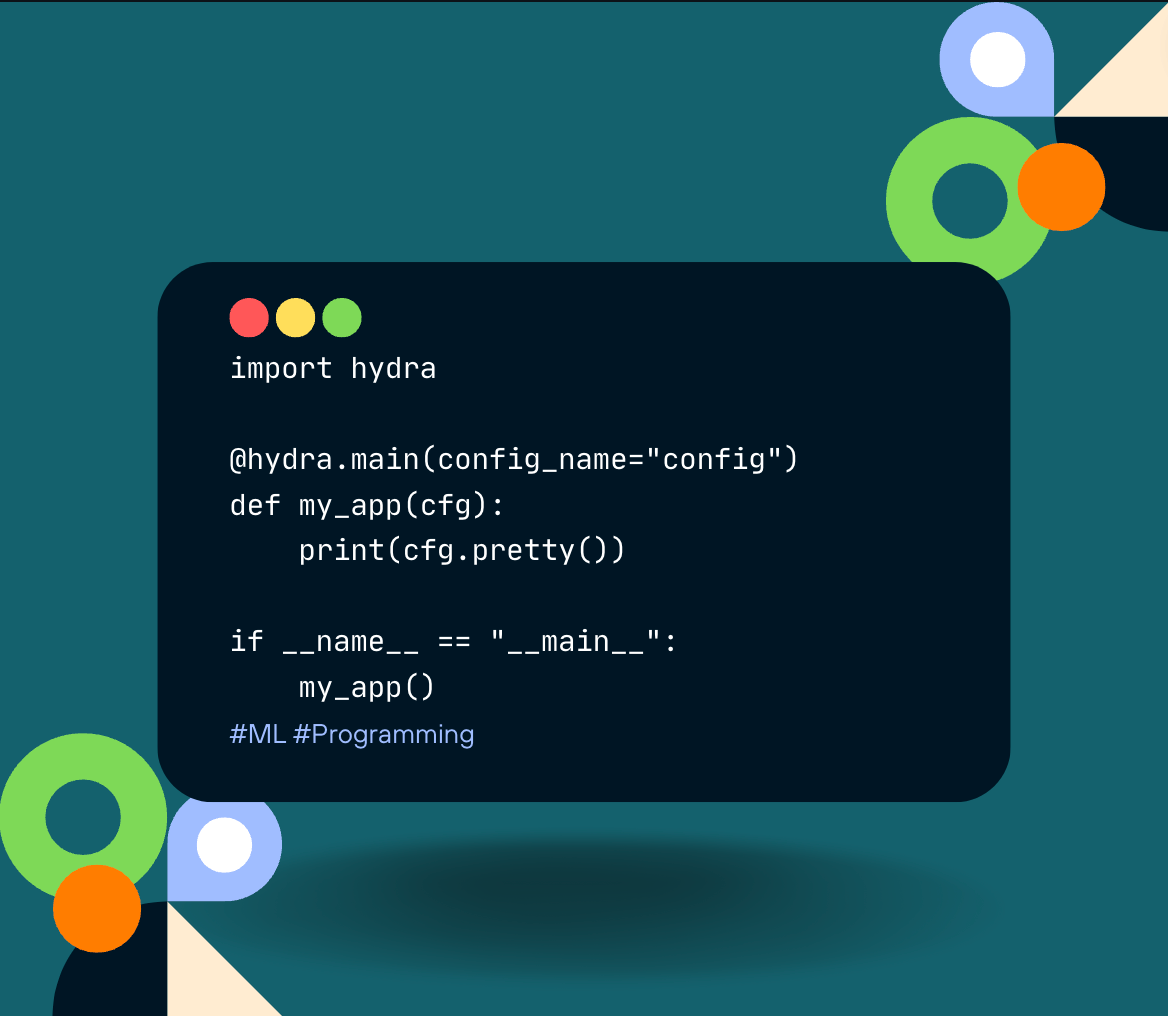

如何使用Hugging Face的LLMs权重?

我们将使用Falcon7b,一个预训练的因果解码器-only模型,通常需要进一步微调才能适用于大多数用例。然而,对于文本生成,与其他各种模型相比,它展现了卓越的性能。

导入必要的库

!pip install transformers

!pip install torch

from transformers import AutoTokenizer, AutoModelForCausalLM

import transformers

import torch加载模型和分词器

下一步是实例化一个AutoTokenizer对象,并加载预训练Falcon模型的分词器和模型。

model = "tiiuae/falcon-7b-instruct"

tokenizer = AutoTokenizer.from_pretrained(model)使用Hugging Face Transformers Pipeline构建模型管道

该代码使用Transformers库创建了一个文本生成管道。它将任务指定为“文本生成”,并要求预训练模型和分词器。计算配置为使用16位浮点数数据类型。

!pip install einops

!pip install accelerate

pipeline = transformers.pipeline(

"text-generation",

model=model,

tokenizer=tokenizer,

torch_dtype=torch.bfloat16,

trust_remote_code=True,

device_map="auto",

)模型推理

任务是利用构建的管道打印结果。’prompt’变量包含初始文本,作为起点。我们配置管道生成最多200个令牌,启用抽样,并在每个步骤考虑前10个可能的令牌。

prompt = "写一首关于埃隆·马斯克解雇Twitter员工的诗"

sequences = pipeline(

prompt,

max_length=200,

do_sample=True,

top_k=10,

num_return_sequences=1,

eos_token_id=tokenizer.eos_token_id,

)

for seq in sequences:

print(f"结果:{seq['generated_text']}")

输出

未来的可能性和伦理考虑

语言模型的未来充满了无数等待探索的可能性。LLM的进展有潜力创造出与人类难以区分的虚拟助手,从而改变客户服务和人机交互。增强的语言理解和生成能力可以带来更无缝和沉浸式的虚拟现实体验。LLM也可以在跨语言障碍和促进全球交流方面发挥重要作用。

然而,随着LLM的不断发展,伦理考虑变得至关重要。

- 透明度、问责制和偏差缓解技术对确保LLM的负责任开发和使用至关重要。

- 必须制定严格的指导方针和法规,以解决误导、数据隐私和潜在的滥用问题。

- 此外,研究人员、开发人员和决策者之间的合作是至关重要的,以促进道德实践并保护个人和整个社会的利益。

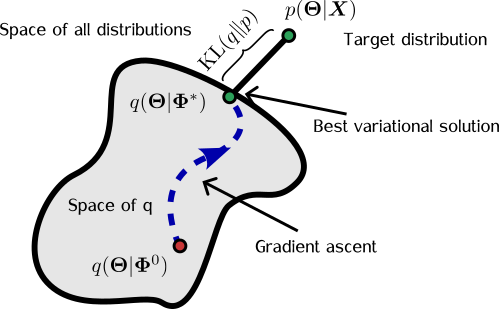

LLM的微调

微调过程涉及在特定任务的数据集上训练基本LLM,其中模型学习生成与所需指令或指南相一致的响应或输出。这个微调过程允许模型适应其语言生成能力,以满足手头任务的特定要求。

指令调整的LLM在需要高度控制或遵守特定指南的情况下具有特定的效用。例如,在聊天机器人应用中,微调指令调整的LLM允许生成更具上下文适应性、特定于领域或与所需的对话指南一致的响应。

通过使用任务特定的指导方针微调基本LLM,开发人员可以创建更专业和有针对性的语言模型。这个过程增强了模型的性能,并使其能够生成在特定应用中表现出色的定制输出。

进化LLM的实际例子

LLM的进化带来了许多具有重大影响的实际应用。

- 进化的LLM可以通过为用户查询提供个性化和上下文感知的响应来革新客户支持系统。

- 进一步简化内容创建流程,可以在各个平台上实现更快速和更有吸引力的内容生成。

- 语言翻译可以变得更加准确和细致,促进跨文化交流。

此外,进化的LLM在医疗保健、法律和教育领域具有潜力。

- 在医疗保健领域,这些模型可以协助医学诊断,根据患者症状和病史推荐治疗方案。

- 在法律领域,LLM可以协助法律研究,分析大量法律文件,并为案件提供见解。

- 在教育领域,LLM可以为学生提供个性化的学习体验,根据他们的特定需求和学习风格提供量身定制的教育内容。

结论

从GPT-3到未来的一代LLM的演变,标志着自然语言处理领域的一个重要里程碑。这些先进的模型有潜力革新各个行业,简化流程并增强人机交互。

然而,语言模型的进步也伴随着局限性、挑战和伦理考虑,这些都需要引起关注。负责任地开发和部署大型语言模型(LLMs),并支持持续的研究和协作,是至关重要的。这些努力将塑造语言模型的未来,使我们能够在减少潜在风险的同时获得它们的好处。LLMs的旅程仍在继续,为AI的进步和我们与技术互动的转变带来了巨大的希望。

关键点

- LLMs的演变代表了自然语言处理的一个重要里程碑,可以实现革命性的应用和改进的人机交互。

- 认识和解决与LLMs相关的局限和挑战,如偏见和伦理考虑等,以确保负责任的开发和部署。

- 持续的研究、协作和负责任的LLMs使用将塑造AI的未来,在语言理解和互动方面开启变革性的可能性。

常见问题

本文中显示的媒体不归Analytics Vidhya所有,作者自行决定使用。