高效的小型语言模型:微软的13亿参数phi-1.5

Efficient small-scale language model Microsoft's 1.3 billion parameter Phi-1.5

当你觉得关于大型语言模型(LLMs)的新闻已经足够多的时候,微软研究院又来打扰市场了。2023年6月,微软研究院发布了一篇名为“教科书就是你所需要的”的论文,介绍了phi-1,一个针对代码的新型大型语言模型。phi-1是一个基于Transformer的模型,具有13亿个参数,通过在8个A100s GPU上进行为期4天的训练,使用了来自网络上的“教科书质量”的数据。

看起来LLMs越来越小了。

phi-1.5是什么?

现在微软研究院向您介绍phi-1.5,一个具有13亿个参数的Transformer,它使用与phi-1相同的数据源进行训练。如上所述,phi-1是在高质量的教科书数据上进行训练的,而phi-1.5仅使用合成数据进行训练。phi-1.5使用了32个A100-40G GPU,并成功地在8天内进行了训练。phi-1.5的目标是打造一个开源模型,可以在研究社区中发挥作用,使用非限制性的小型模型,允许您探索LLMs的不同安全挑战,如减少毒性、增强可控性等。

通过使用“合成数据生成”方法,phi-1.5在自然语言测试中的表现相当于5倍于更大模型的模型,并且在更困难的推理任务上表现优于大多数LLMs。

相当令人印象深刻,对吧?

该模型的学习过程非常有趣。它从各种来源获取数据,包括来自StackOverflow的Python代码片段,合成的Python教科书以及由GPT-3.5-turbo-0301生成的练习。

解决毒性和偏见问题

LLMs面临的一个主要挑战是毒性和偏见内容。微软研究院旨在克服这种持续存在的有害/冒犯性内容和宣传特定意识形态的内容。

用于训练模型的合成数据相比于其他LLMs(如Falcon-7B和Llama 2-7B)生成的响应具有更低的生成有毒内容的倾向,如下图所示:

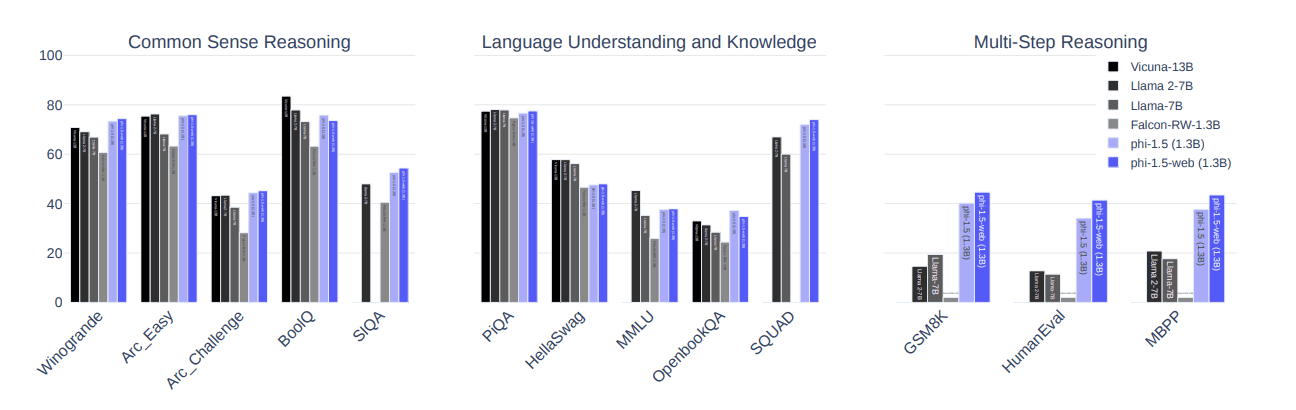

基准测试

下图显示了phi-1.5在常识推理、语言技能和多步推理等3个基准测试中略优于最先进的模型,如Llama 2-7B、Llama-7B和Falcon-RW-1.3B。

如何做到的?

与从互联网提取的数据相比,类似教科书的数据的使用使LLMs的数据使用有所不同。为了进一步评估模型对有毒内容的处理方式,还使用了ToxiGen,并设计了86个提示,并进行了人工标记为“通过”、“失败”或“不理解”,以更好地了解模型的局限性。

据此,phi-1.5通过了47个提示,失败了34个提示,不理解了4个提示。通过人工评估模型生成的响应,显示phi-1.5在与其他知名模型相比得分更高。

主要要点:

以下是关于phi-1.5您应该了解的主要要点:

- 它是基于Transformer的模型

- 它是一个专注于下一个单词预测目标的LLM

- 它在300亿个标记上进行了训练

- 它使用了32个A100-40G GPU

- 它在8天内成功训练完成

Nisha Arya是一位数据科学家、自由职业技术作家和VoAGI社区经理。她对提供数据科学职业建议或教程以及围绕数据科学的理论知识特别感兴趣。她还希望探索人工智能在延长人类寿命方面的不同方式。作为一个热心的学习者,她寻求拓宽自己的技术知识和写作能力,同时帮助指导他人。