在鸽子群中扔只猫?用大型语言模型增强人类计算

Drop a cat in a flock of pigeons? Enhance human computation with large-scale language models

生成人工智能时代提供了改进众包工作的机会,而不一定是替代它

我一直对词源学很感兴趣。往往,我们熟悉的词语和短语背后都有一个有趣的故事,它们是如何获得现在的含义的。随着时代的变迁和变化而变形。18世纪,匈牙利作家和发明家沃尔夫冈·冯·肯佩伦制造了一个名为“机械土耳其人”的国际象棋机器。传说中,“机械土耳其人”巡回欧洲,在国际象棋的传奇对决中击败了拿破仑·波拿巴和本杰明·富兰克林等著名人物。直到后来,秘密才揭示出来,原来是一个真正的国际象棋高手躲藏在地板下的柜子里,控制着机器的走棋。

这个故事启发了亚马逊于2005年推出的“亚马逊机械土耳其人”众包平台的命名。该平台旨在解决无法通过现有替代方案解决的任务,并需要人类的输入或智能。正是在这个背景下,“人工人工智能”的概念开始形成,人类在机器能力不足时充当智能的源泉。我们已经走过了很长的路程,来到了一个全新的“人工人工人工智能”的概念的前沿。是的,你没看错。有三个“人工”。在你试图用前额砸开这个核桃之前,让我们快速回顾一下一些记忆之路。

众包的早期阶段

詹姆斯·苏罗威基在他2004年出版的书《智慧来自群体》中探索和综合了形成一个明智群体所需的属性——一个群体往往能够做出比群体中任何个体更好的决策。他将意见多样性、独立判断和分散知识视为实现这一目标的重要属性。2006年,杰夫·豪在他为《连线》杂志撰写的一篇文章中创造了“众包”这个词,将“群体”和“外包”合二为一,讨论了企业如何开始通过向分布式在线社区发出公开呼吁来利用集体能力完成某些任务。

亚马逊机械土耳其人在首次推出后蓬勃发展,几年内,全球数十万人找到了在该平台上完成任务的机会,从而谋生。这在全球范围内引发了众包平台的增长,铸就了一个新的在线微任务众包经济。研究人员和从业者开始依赖众包平台来完成各种任务,并证明即使是高度复杂的任务也可以进行分解和众包。提出了支持众包工人有效完成任务的系统和工具。

2009年,ImageNet的发布推动了整个机器学习领域的发展。通过亚马逊机械土耳其人的众包方式,该项目收集了超过320万张图像,分为12个子树,有超过5000个同义词集,这是一项巨大的数据收集工作[1]。这为包括物体识别和图像分类在内的多个计算机视觉任务提供了前所未有的机会。

让我们不要忘记,这一进展伴随着一系列的考验和困难。许多人意识到依赖人类生成的数据存在认知和系统偏见的危险。2013年,一群众包社区中著名的研究人员撰写了一篇名为《众包工作的未来》的论文,反思了该范式的现状以及亟需解决的一系列挑战[2]。尽管取得了相当大的进展,但这些挑战中的许多仍然没有解决。在数据质量(例如偏见的传播)、平台上的权力不对称、低微的小时工资、不公平的工作拒绝、不可见的劳动、不健康的工作环境等方面存在很多问题。尽管一些人认为这是一种破碎的工作范式,但显然,众包的力量在历史时间线上留下了显著的成果,并为技术进步的速度做出了不可磨灭的贡献。

引人入胜的生成人工智能时代

当今世界上的主流媒体普遍陷入了关于生成式人工智能和大型语言模型民主化的广泛叙事中。预计和意想不到的方式将继续有更多的生活受到人工智能的影响。然而,背后辛勤工作的人类是这场人工智能革命的推动力量。正如玛丽·格雷(Mary Gray)和西德·苏里(Sid Suri)在《幽灵工作》(Ghost Work)一书中所说:“如果我们“审查人工智能的阴影,我们会发现驱动它的人类。”

夸大的预测和点击标题将人类在这个时代的角色比喻为焦虑的鸽子,并将大型语言模型(LLMs)比作大胆的猫,而这只隐喻的猫扰乱了鸽群,使它们四处飞散。但是,这个新一代生成式人工智能模型的到来对人类输入意味着什么?在塑造未来技术的过程中,人类输入的需求在很大程度上是否已经被消除?在本文的剩余部分,我将论证这个问题的答案是明确的否定,并且我们应该期待的主要转变是人类输入的性质将继续需要。

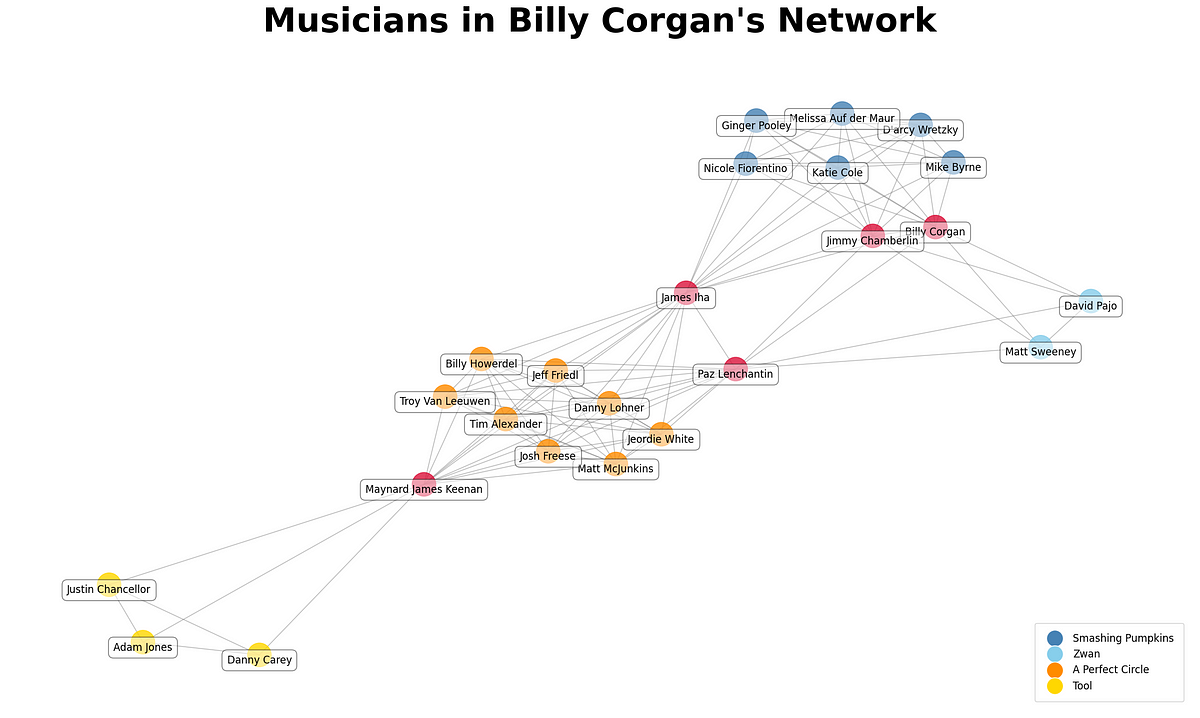

我最近与他人合著了一篇研讨会论文,探讨了如何使人类计算工作流程适应生成式人工智能模型的出现。这项工作在今年早些时候在ACM CHI 2023(全球最重要的人机交互会议)的生成式人工智能研讨会上被介绍。我们强调了大型语言模型(LLMs)在增强现有众包工作流程中的潜在作用,并讨论了如何从实证角度评估这些工作流程。

众包工作流程简介

众包工作流程是一种管理大规模任务如何分解为小任务由众包工作者完成的独特模式。基于众包的文字处理器Soylent将查找-修正-验证的工作流程应用于通过将任务分成生成和审查文字的阶段来生成高质量的文本。这使得“作者可以召集Mechanical Turk工作者按需缩短、校对和编辑他们文档的部分内容。”在创建图像描述时,迭代和投票的工作流程被应用,工作者首先被要求撰写图像描述(例如,最终目标是帮助盲人)。随后的投票任务用于收敛到最佳描述。[6] 映射-归约工作流程被提议用于“将工作分解为可以并行完成的任务,将任务分配给工作者,并管理它们之间的依赖关系。”与之类似,像CrowdWeaver这样的工具已经被提议用于管理复杂的工作流程,支持任务之间的数据共享,并提供监控工具和实时任务调整能力。

利用LLMs增强众包工作流程

语言模型的出现不太可能使这些工作流程、框架和工具完全平凡。相反,众包社区正处于独特的位置,可以通过借鉴几十年来围绕有效工作流程、人机协同方法和构建混合人工智能系统的研究成果,来充分利用LLMs带来的好处。

以人为中心的技术开发视角侧重于增强人们日常生活中的体验,提升人们的能力。如果LLMs确实可以帮助众包工作者完成任务,那么应该以一种能够赋予工作者更准确、更快速完成任务或以某种方式改善他们整体体验的方式来接纳和整合它们。

信息检索领域的研究人员(我在过去十年中参与其中)最近考虑了LLMs的普及对于人工标注者在评估相关性判断中的角色可能意味着什么。他们提出了一种人类和LLMs之间协作的连续谱,用于产生相关性判断(从人类判断到完全自动评估,类似于流行的自动化程度)。作者们探讨了在注释任务中将LLMs纳入辅助能力的潜在好处,并将其与这样做的风险进行了对比。显然,LLMs可以减少创建评估集的注释成本。然而,目前尚不清楚这样的数据集是否可能与由人类创建的数据集存在系统性差异,以及这样的人工制品如何影响信息检索系统的评估,从而影响这类系统的未来设计。

除了在工作流程中支持个别的写作或分类任务外,研究人员还在探索将LLMs应用于辅助众包工作者的方法。刘等人结合了GPT-3的生成能力和人类的评估能力,创建了一个新的自然语言推理数据集,当作为训练集时可以产生更有效的模型。在类似的思路中,其他人引入了一个“生成式注释助手”来帮助生成动态对抗性数据集,极大地提高了收集速度。然而,关于LLMs如何改进众包工作流程的效果以及如何对这些工作流程进行整体评估,还存在许多不太清楚的开放问题。

前方多道阻碍?

与人类类似,语言模型也可能存在偏见和不公平性。一方面,先前的研究表明,人类注释员在完成注释任务时容易受到自己观点的影响,导致系统性偏见渗入到所得数据集中 [12]。其他研究者提出了一些检查清单,以应对或报告在注释过程中可能出现的认知偏见 [13]。另一方面,最近的研究揭示了语言模型中存在的歧视立场和刻板偏见 [14, 15]。

人类计算和众包研究社区(HCOMP)已经设计了许多有效的方法、界面、度量和工具,以确保从众包工作者那里收集到高质量的数据。只是时间问题,我们将共同解决如何在决策流程中整合语言模型时提供与数据质量相关的保证。

表面上看,将语言模型整合到众包工作流程中似乎相当简单。但与大多数复杂系统相关的解决方案提议一样,说起来容易做起来难。众包涉及许多不同的利益相关者:那些希望收集大规模注释的任务请求者、愿意为回报而参与的众包工作者、提供基础设施并作为交易市场的平台,以及间接使用由下游努力开发或构建的产品或技术的最终用户。将语言模型纳入工作流程的影响有可能以不同方式影响每个利益相关者。

如果众包工作者能够通过利用语言模型在智能工作流程中提高效率和效能,那么有可能在不增加成本的情况下完成更多工作。然而,我们还需要进一步研究,更好地了解将语言模型作为众包工作流程的一部分所涉及的风险和回报。谁将负责设计、开发和整合语言模型到这样的工作流程中,考虑到潜在的问责需求?

众包工作者一直以来一直被忽视,他们需要改进自己的生产力以及他们所工作的环境和条件。现在,众包平台和任务请求者是否应该共同负责更好地了解如何为工作者提供基于语言模型的解决方案,以帮助他们成功完成任务,并改善和增强他们的工作体验?

人造人造人造智能和可能的未来

最近的一项案例研究探讨了从“人类”中众包的文本摘要任务中产生的数据到底有多少是真正由人类生成的。作者发现有证据支持他们在亚马逊众包平台的研究中,有超过30%的众包工作者已经开始依赖于语言模型 [16]。虽然该研究仅针对了44名工作者,而且这些数字可能不太可靠,但这确实反映了更多众包工作者可能转向基于语言模型的解决方案,以帮助他们提高生产力、最大化收入并改善他们在众包市场中的时间。这就是“人造人造人造智能”的概念出现的地方——众包工作者潜在地利用人工智能(来自语言模型的辅助)根据需求提供所谓的“人类”输入。

我们还需要进一步考虑语言模型相对于人类的透明度和可解释性。当众包工作者完成注释或其他需要决策的任务时,任务请求者可以通过后续问题提取有意义的理由。众包工作者有能力在需要时提供这些洞察力。目前,语言模型还无法做到这一点。是的,有关于模型可解释性的方法,但没有一种方法能够证明其在与人类两端一样有效的水平上的效果。这种将语言模型视为“黑盒子”的看法可能会阻碍任务请求者和众包平台的采用,同时也会妨碍众包工作者对这些工具的适当依赖。

人类和LLMs?有着无尽的可能性和一大堆引人入胜的问题,却只有少数闪烁的答案。抓住机遇,将这项技术进步整合到改善群体工作中,就像是在帆船中迎风而行,而不是扰蜂窝。让我们忙碌起来,一个美好的未来在等待着我们,当我们能够以人类为核心塑造它。

参考文献

- Deng, J., Dong, W., Socher, R., Li, L. J., Li, K., & Fei-Fei, L. (2009, 六月). Imagenet: 一个大规模的分层图像数据库. 在2009年IEEE计算机视觉与模式识别会议中 (pp. 248–255). IEEE.

- Kittur, A., Nickerson, J.V., Bernstein, M., Gerber, E., Shaw, A., Zimmerman, J., Lease, M. and Horton, J. (2013, 二月). 众包工作的未来. 在2013年计算机支持的协同工作会议论文集中 (pp. 1301–1318).

- Gray, M. L., & Suri, S. (2019). 幽灵工作: 如何阻止硅谷建立新的全球下层阶级. Eamon Dolan Books.

- Allen, G., He, G., Gadiraju, U. Power-up! 生成模型对人类计算工作流程能做什么?在ACM人类因素计算系统国际会议的生成AI研讨会论文集中 (CHI 2023)。

- Bernstein, Michael S., Greg Little, Robert C. Miller, Björn Hartmann, Mark S. Ackerman, David R. Karger, David Crowell, and Katrina Panovich. (2010). Soylent: 一个内置众包的文字处理器. 在第23届年度ACM用户界面软件和技术研讨会论文集中 (pp. 313–322).

- Little, G., Chilton, L. B., Goldman, M., & Miller, R. C. (2009, 六月). Turkit: 用于机械土耳其人迭代任务的工具. 在ACM SIGKDD人类计算研讨会论文集中 (pp. 29–30).

- Kittur, A., Smus, B., Khamkar, S., & Kraut, R. E. (2011, 十月). Crowdforge: 众包复杂工作. 在第24届年度ACM用户界面软件和技术研讨会论文集中 (pp. 43–52).

- Kittur, A., Khamkar, S., André, P. and Kraut, R. (2012, 二月). CrowdWeaver: 可视化管理复杂的众包工作. 在ACM 2012计算机支持的协同工作会议论文集中 (pp. 1033–1036).

- Faggioli, G., Dietz, L., Clarke, C., Demartini, G., Hagen, M., Hauff, C., Kando, N., Kanoulas, E., Potthast, M., Stein, B. and Wachsmuth, H. (2023). 关于大型语言模型在相关性判断中的观点. arXiv预印本 arXiv:2304.09161.

- Liu, Z., Roberts, R.A., Lal-Nag, M., Chen, X., Huang, R. and Tong, W. (2021). 以AI为基础的语言模型推动药物发现和开发. 《当代药物发现》, 26(11), pp.2593–2607.

- Bartolo, M., Thrush, T., Riedel, S., Stenetorp, P., Jia, R. and Kiela, D. (2021). 循环中的模型: 帮助众包工人的生成性注释助手. arXiv预印本 arXiv:2112.09062.

- Hube, C., Fetahu, B. and Gadiraju, U. (2019, 五月). 理解和减轻众包主观判断中的工人偏见. 在2019年CHI人因计算系统会议论文集中 (pp. 1–12).

- Draws, T., Rieger, A., Inel, O., Gadiraju, U., & Tintarev, N. (2021, 十月). 对抗众包中的认知偏见的检查清单. 在AAAI人类计算和众包会议论文集中 (Vol. 9, pp. 48–59).

- Abid, A., Farooqi, M. and Zou, J. (2021, 七月). 大型语言模型中持久的反穆斯林偏见. 在2021年AAAI/ACM人工智能、伦理和社会学会议论文集中 (pp. 298–306).

- Nadeem, M., Bethke, A. and Reddy, S. (2020). StereoSet: 测量预训练语言模型中的刻板偏见. arXiv预印本 arXiv:2004.09456.

- Veselovsky, V., Ribeiro, M. H., & West, R. (2023). 人工人工人工智能: 众包工人广泛使用大型语言模型进行文本生成任务. arXiv预印本 arXiv:2306.07899.