麻省理工学院和哈佛大学的研究人员提出了一种名为FAn的全面人工智能系统,它弥合了最先进的计算机视觉和机器人系统之间的差距,为分割、检测、跟踪和跟随任何物体提供了端到端的解决方案

Researchers from MIT and Harvard have proposed a comprehensive artificial intelligence system called FAn, which bridges the gap between state-of-the-art computer vision and robotics systems, providing an end-to-end solution for segmentation, detection, tracking, and following of any object.

在一项新的人工智能研究中,麻省理工学院和哈佛大学的研究人员引入了一种开创性的框架,名为“Follow Anything”(FAn)。该系统解决了当前物体跟踪机器人系统的局限性,并提供了实时、开放式物体跟踪和跟随的创新解决方案。

现有物体跟踪系统的主要不足包括由于识别类别的固定集合而无法适应新物体以及在指定目标物体时缺乏用户友好性。新的FAn系统通过提供一种开放式方法来解决这些问题,可以无缝地通过文本、图像或点击查询检测、分割、跟踪和跟随各种各样的物体,以适应新物体。

所提出的FAn系统的核心特点可以总结如下:

- Line 开源了“japanese-large-lm”:一个具有36亿参数的日语语言模型

- 生成对抗网络(GANs)用于图像增强

- 2023年8月最佳AI工具的联盟营销(Affiliate Marketing)

开放式多模态方法:FAn引入了一种新颖的方法,可以实时检测、分割、跟踪和跟随给定环境中的任何物体,无论其类别如何。

统一部署:该系统专为机器人平台设计,侧重于微型飞行器,可以有效地集成到实际应用中。

鲁棒性:该系统包含重新检测机制,以处理在跟踪过程中被遮挡或暂时丢失的跟踪对象的情况。

FAn系统的根本目标是赋予配备机载摄像头的机器人系统识别和跟踪感兴趣物体的能力。这涉及确保物体在机器人移动时仍然在摄像头的视野内。

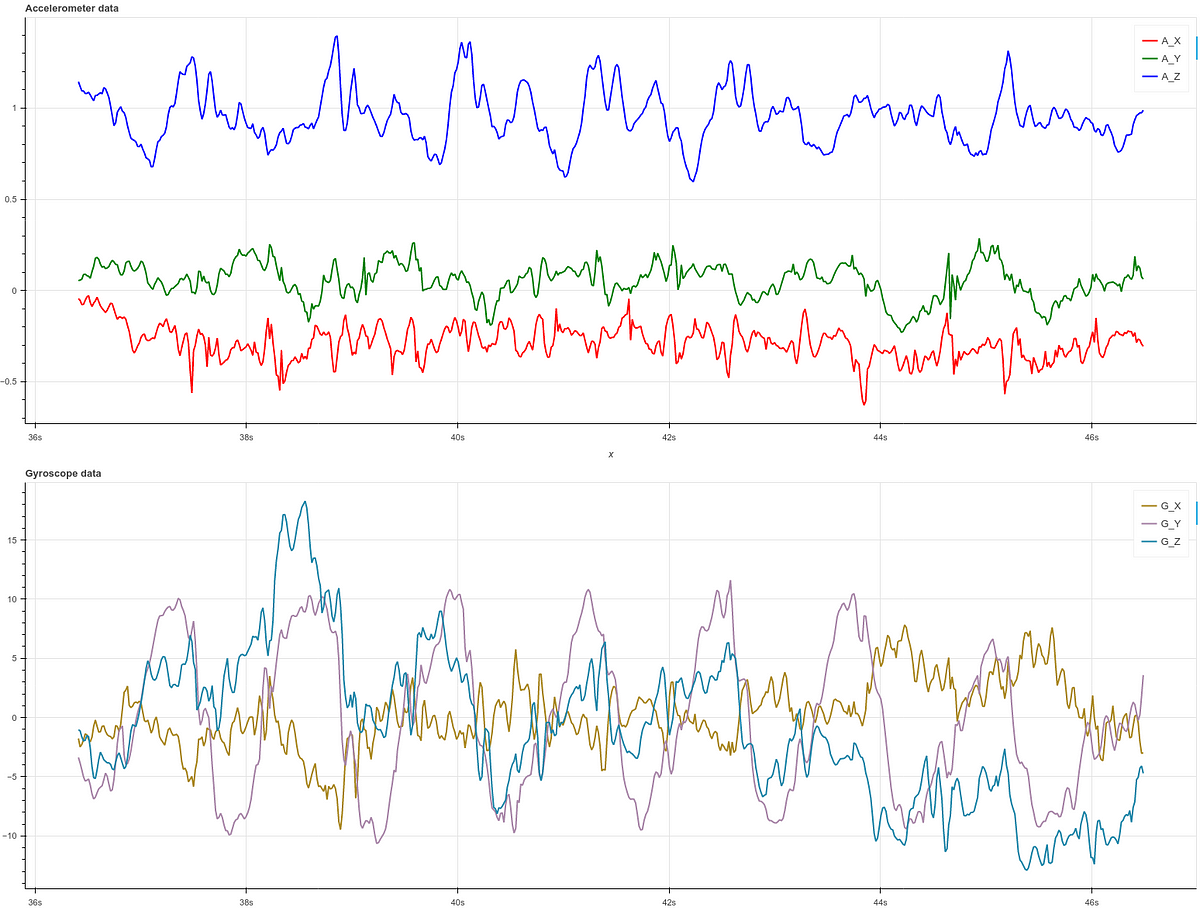

FAn利用最先进的Vision Transformer(ViT)模型来实现这一目标。这些模型经过优化,以实现实时处理,并合并为一个统一的系统。研究人员利用各种模型的优势,如Segment Anything Model(SAM)用于分割、DINO和CLIP用于从自然语言中学习视觉概念,以及轻量级检测和语义分割方案。此外,使用(Seg)AOT和SiamMask模型实现了实时跟踪。还引入了一个轻量级的视觉服务控制器来控制物体跟随过程。

研究人员进行了全面的实验,评估了FAn在零样本检测、跟踪和跟随场景中的性能。结果表明,该系统能够无缝高效地实时跟踪感兴趣的物体。

总之,FAn框架代表了一个全面的实时物体跟踪和跟随解决方案,消除了封闭式系统的限制。它的开放式特性、多模态兼容性、实时处理以及对新环境的适应能力使其成为机器人技术的重要进展。此外,团队开源系统的承诺凸显了其在各种实际应用中的潜力。