非常大的语言模型及其评估方法

Large Language Models and Evaluation Methods

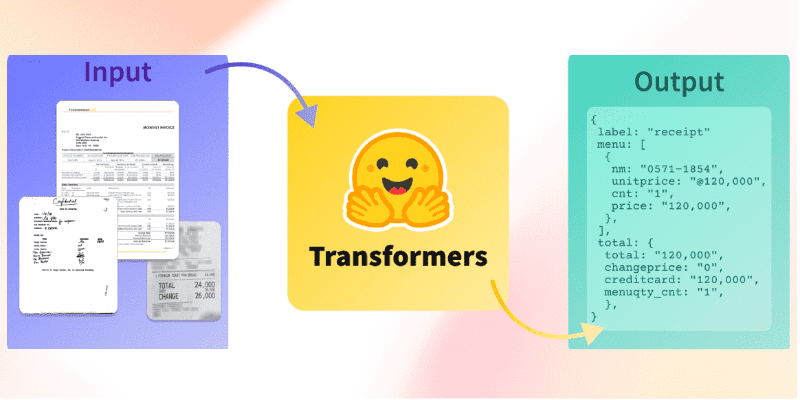

大型语言模型现在可以通过Evaluation on the Hub在零-shot分类任务上进行评估!

零-shot评估是研究人员衡量大型语言模型性能的一种常用方法,因为这些模型已被证明在训练过程中可以学习到能力,而无需显式展示标记示例。反向缩放奖是最近社区努力的一个例子,通过在模型大小和系列中进行大规模零-shot评估,发现较大模型在某些任务上的性能可能低于较小模型。

在Hub上实现语言模型的零-shot评估

Evaluation on the Hub可以帮助您在不编写代码的情况下评估Hub上的任何模型,并由AutoTrain提供支持。现在,Hub上的任何因果语言模型都可以以零-shot方式进行评估。零-shot评估可以衡量训练模型生成给定标记集的可能性,而无需任何标记训练数据,这使得研究人员可以跳过昂贵的标注工作。

我们对此项目进行了AutoTrain基础设施升级,以便可以免费评估大型模型🤯!对于用户来说,要想知道如何编写自定义代码来在GPU上评估大型模型是昂贵且耗时的。例如,一个具有660亿参数的语言模型可能需要35分钟才能加载和编译,使得大型模型的评估只对那些拥有昂贵基础设施和丰富技术经验的人可行。通过这些变化,任何社区成员都可以在3.5小时内对具有6600亿参数的模型在零-shot分类任务上进行评估。目前,Evaluation on the Hub支持评估多达6600亿参数的模型,更大模型的支持即将推出。

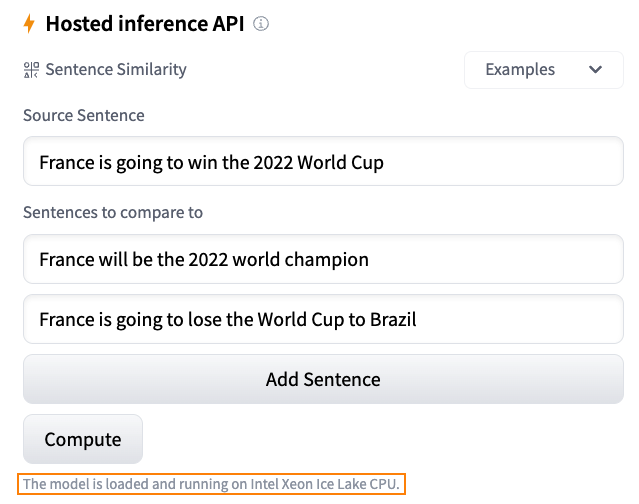

零-shot文本分类任务接受包含一组提示和可能完成的数据集。在内部,完成的文本与提示连接,每个标记的对数概率求和,然后进行归一化并与正确完成进行比较,以报告任务的准确性。

在这篇博文中,我们将使用零-shot文本分类任务来评估WinoBias上的各种OPT模型,WinoBias是一个关于职业与性别偏见的共指任务。WinoBias衡量模型在提到职业的句子中更可能选择一个刻板的代词来填充,我们观察到结果表明,模型大小与模型在性别方面的刻板关联趋势相反。

案例研究:WinoBias任务上的零-shot评估

WinoBias数据集被格式化为一个零-shot任务,其中分类选项是完成的文本。每个完成文本的代词不同,目标是与职业相对应的反刻板完成文本(例如,“developer”刻板上是男性主导的职业,因此“she”是反刻板代词)。请参见下面的示例:

接下来,我们可以在Evaluation on the Hub界面上选择这个新上传的数据集,使用text_zero_shot_classification任务,选择要评估的模型,然后提交我们的评估作业!当作业完成时,您将收到电子邮件通知,通知您autoevaluator bot已在模型的Hub存储库上打开了一个新的拉取请求,并附上了结果。

绘制WinoBias任务的结果,我们发现较小的模型更有可能选择反刻板的代词来填充句子,而较大的模型更有可能在文本中学习到性别与职业之间的刻板关联。这与其他基准(例如BIG-Bench)的结果一致,这些基准显示更大、功能更强大的模型更可能存在性别、种族、民族和国籍方面的偏见,并且先前的研究表明,更大的模型更有可能生成有害文本。

为每个人提供更好的研究工具

开放科学在社区驱动的工具开发方面取得了巨大进展,例如EleutherAI的语言模型评估工具和BIG-bench项目,这些工具使研究人员能够轻松理解最新模型的行为。

Evaluation on the Hub是一个低代码工具,可以简单比较一组模型在FLOPS或模型大小等方面的零-shot性能,并将一组模型在特定语料库上训练的性能与另一组模型进行比较。零-shot文本分类任务非常灵活,可以使用任何可以通过少数单词进行排列以形成Winograd模式的数据集,并同时对多个模型进行评估。我们的目标是简化上传新数据集进行评估,并使研究人员能够轻松对其进行基准测试。

这是一个可以使用类似工具来解决的例子研究问题,即反比例缩放问题:虽然较大的模型在大多数语言任务上通常更有能力,但也有一些任务在较大的模型上表现更差。”反比例缩放奖”是一个竞赛,挑战研究人员构建那些较大的模型表现比较差的任务。我们鼓励您尝试在各种模型大小上进行零样本评估,并进行自己的任务测试!如果您发现模型大小存在有趣的趋势,请考虑将您的发现提交给”反比例缩放奖”的第二轮。

给我们反馈吧!

Hugging Face非常期待继续推广最先进的机器学习模型的使用,并包括开发工具,使每个人都能够轻松评估和探索这些模型的行为。我们之前写过关于标准化模型评估方法的重要性,以保持一致性和可重复性,并使评估工具对每个人都易于使用。Evaluation on the Hub的未来计划包括支持针对那些可能不适合将完成的内容与提示进行连接的语言任务的零样本评估,并增加对更大模型的支持。

作为社区的一部分,您可以做出最有价值的贡献之一就是给我们提供反馈!我们很乐意听取您对模型评估的重要事项的意见。请通过在Evaluation on the Hub社区选项卡或论坛上发帖,告诉我们您的反馈和功能需求!