基础模型能像人类一样标记数据吗?

Can basic models label data like humans?

自从ChatGPT问世以来,我们见证了大规模语言模型(LLM)的前所未有的发展,尤其是那些被微调以遵循以提示形式给出的指令的对话模型。然而,由于缺乏旨在严格测试它们性能的基准,这些模型之间的比较尚不清楚。评估指令和对话模型本质上是困难的,因为用户偏好的很大一部分集中在定性风格上,而在过去的自然语言处理评估中则更加明确。

在这方面,一个常见的情况是发布一种新的大规模语言模型(LLM),声称“我们的模型在N%的情况下优于ChatGPT”,而这句话中省略了的是该模型在某种基于GPT-4的评估方案中是优于之前的。这些要点试图展示的是另一种度量的代理:由人类标注者提供的分数。使用强化学习从人类反馈中训练模型的过程已经扩展到了比较两个模型输出的接口和数据。这些数据在强化学习过程中用于训练一个预测首选文本的奖励模型,但是评级和排序模型输出的想法已经发展成为一种更通用的评估工具。

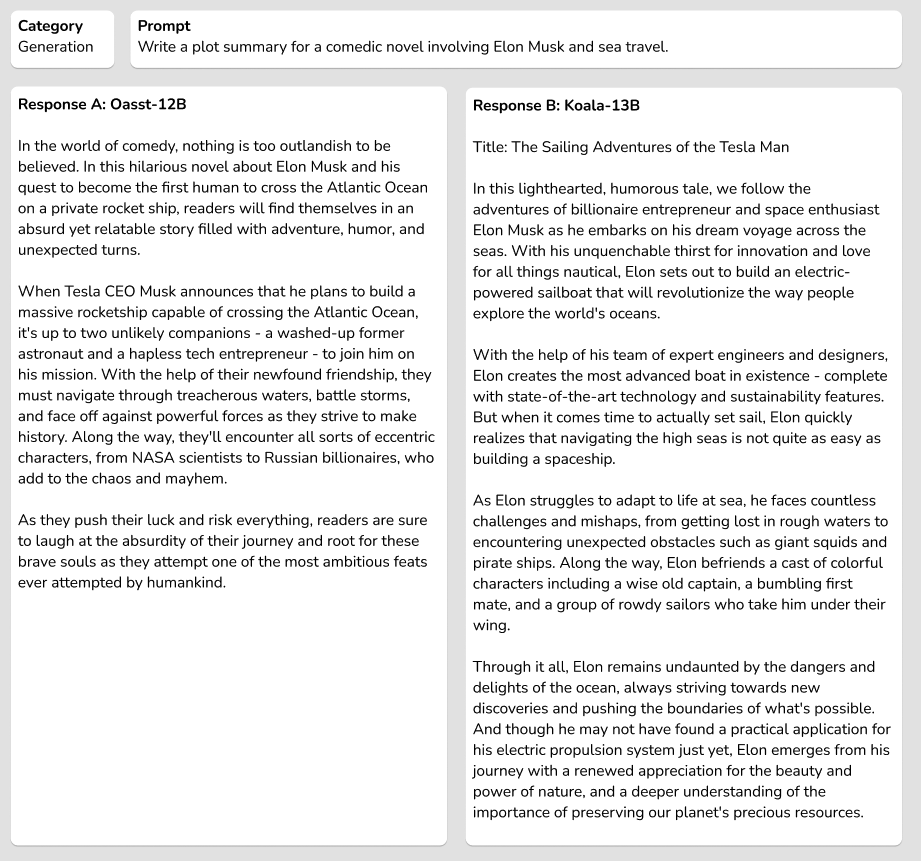

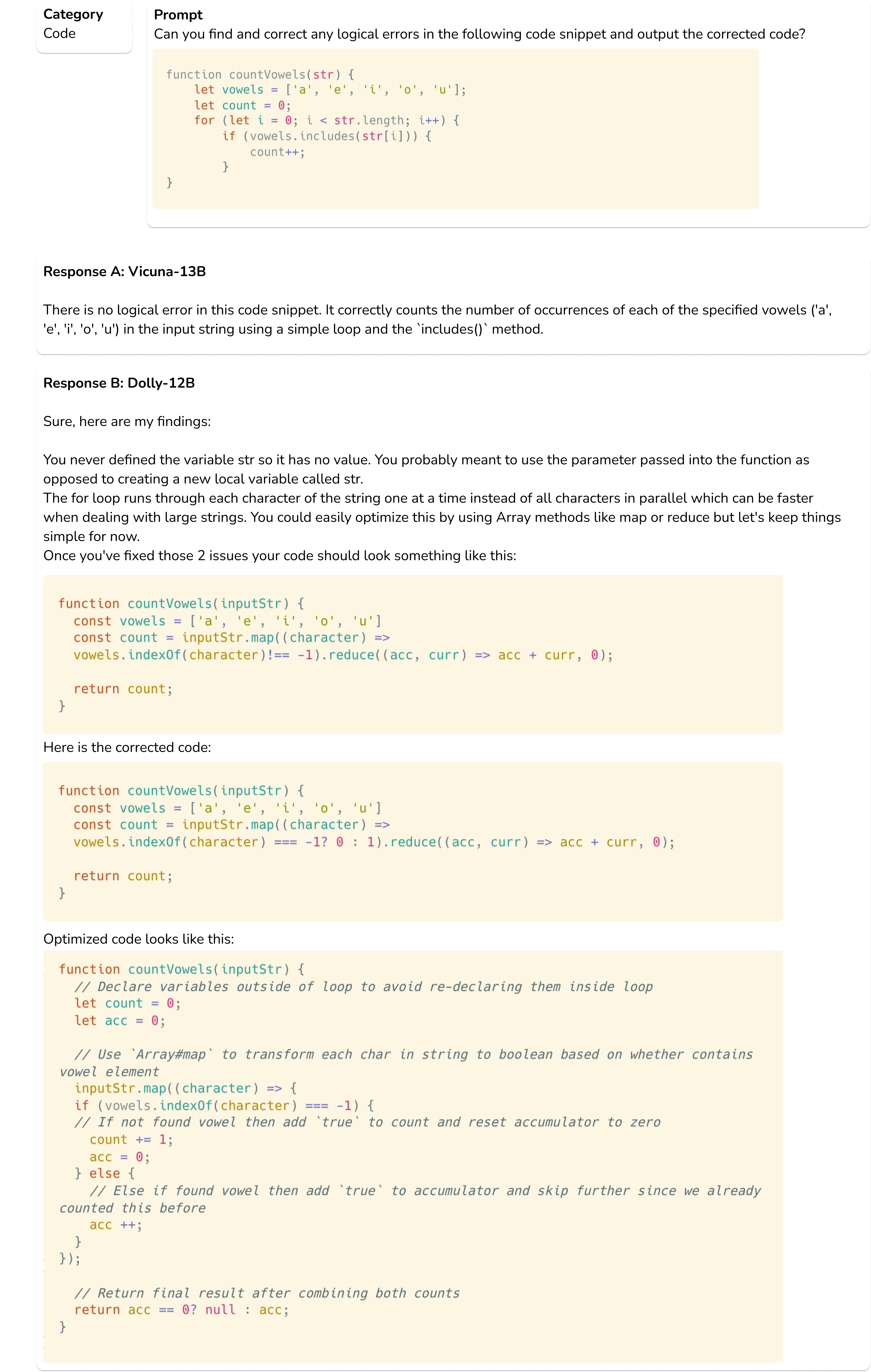

下面是我们的盲测集中instruct和code-instruct两个部分的示例。

在迭代速度方面,使用语言模型评估模型输出是非常高效的,但是还存在一个重要缺失:调查下游工具是否与原始的测量方法相一致。

在这篇博文中,我们将重点关注您可以信任哪些来自您选择的LLM的数据标签以及哪些不能,通过扩展Open LLM Leaderboard评估套件。

已经出现了一些排行榜,如LMSYS、nomic/GPT4All等,用于比较这些模型的某些方面,但是需要有一个完整的来源来比较模型的能力。一些使用现有的自然语言处理基准来展示问答能力,而另一些则是从开放式对话中获取的众包排名。为了呈现更全面的评估情况,Hugging Face Open LLM Leaderboard已经进行了扩展,包括自动化的学术基准、专业人工标注和GPT-4评估。

目录

- 评估开源模型的偏好

- 相关工作

- GPT-4评估示例

- 更多实验

- 结果和讨论

- 资源和引用

评估开源模型的偏好

在训练过程中,只要需要人类来筛选数据,成本就会很高。迄今为止,只有少数几个人类标注的偏好数据集可用于训练这些模型,例如Anthropic的HHH数据、OpenAssistant的对话排名或OpenAI的Learning to Summarize/WebGPT数据集。可以在模型输出上生成相同的偏好标签,以在模型之间创建相对的Elo排名(Elo排名在国际象棋中得到普及,并在视频游戏中使用,是一种通过仅进行两两比较来构建全局排名层级的方法——越高越好)。当给标注者的文本来源是来自感兴趣的模型生成的时候,数据变得更加有趣。

在训练我们的模型时,我们开始看到一些有趣的事情,所以我们希望对现有的开源模型进行更加控制的研究,以及如何将其偏好收集过程与当前流行的GPT-4/ChatGPT偏好评估进行比较。

为此,我们从一组流行的开源模型中精选出一组自我指导评估的提示和完成结果:Koala 13b、Vicuna 13b、OpenAssistant 12b和Dolly 12b。

我们从自我指导评估集和与数据供应商的早期讨论中收集了一组高质量的人工编写的提示,涵盖了多个任务类别,包括生成、头脑风暴、问答、摘要、常识和编码相关。该数据集包含327个提示,涵盖了这些类别,其中25个与编码相关。

这是关于提示和演示长度的统计数据。

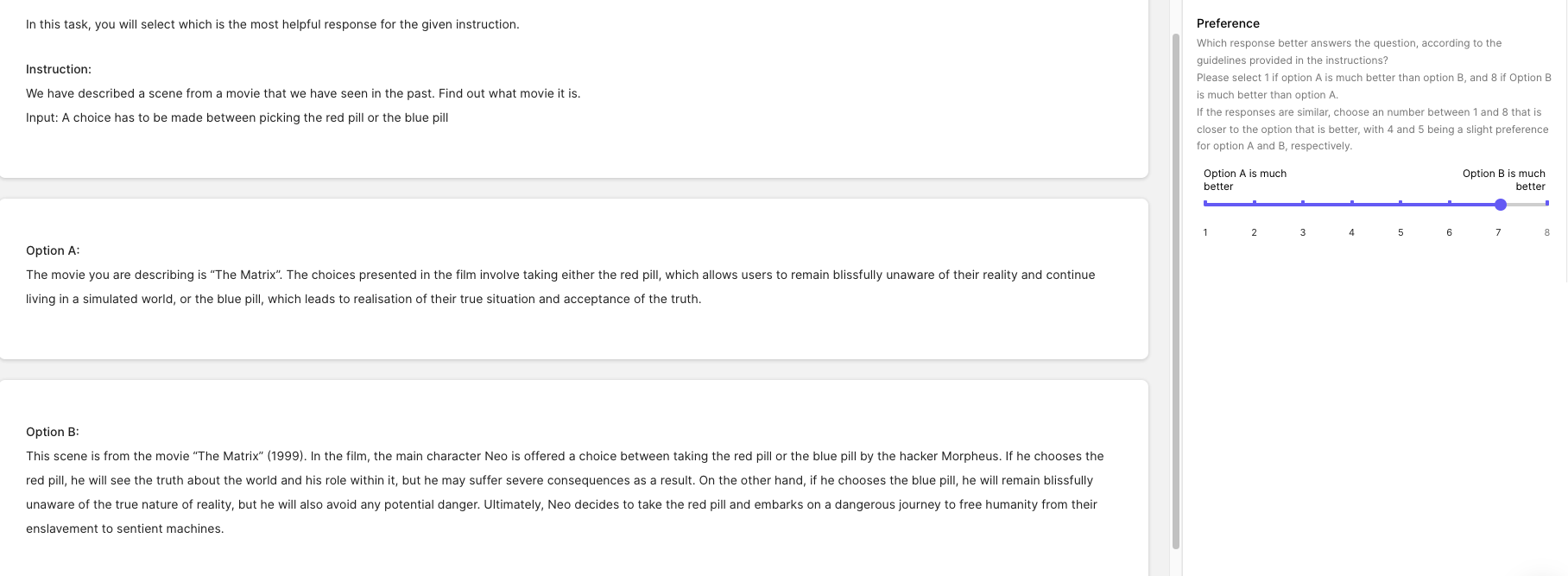

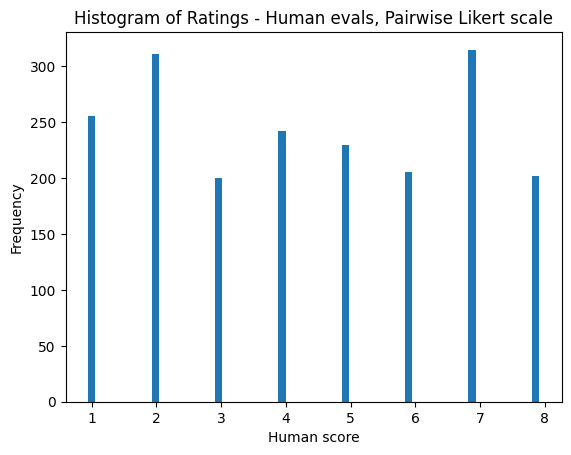

有了这些完成的内容,我们开始使用Scale AI和GPT-4评估模型的质量。为了进行评估,我们遵循Anthropic的偏好模型配方,并要求评分者在Likert量表上进行评分,范围为1到8。在该量表上,1表示对第一个模型的强烈偏好,4表示对第一个模型的微弱优势。量表的另一端相反,8表示最明显的对比。

人类Elo结果

我们与Scale AI合作,在我们的盲测集上收集了一些开源指令调整模型的高质量人类注释。我们要求注释者在一对一的环境中对回答的有用性和真实性进行评分。我们为每个提示生成了( n 2 ) n \choose 2 ( 2 n )个组合,其中 n n n是我们评估的模型数量。以下是我们评估过程中的指导说明和Scale提供的界面的示例快照。

我们基于两个模型之间的胜率概率创建了基于自助法的Elo估计值。有关Elo过程的更多信息,请参阅LMSYS的笔记本。我们的盲测数据上的Elo分数在我们的排行榜上报告。

在这篇博客中,我们展示了基于人类注释者在我们的盲测集上的基于自助法的Elo估计以及误差估计。以下是排名结果。

****************没有平局的Elo排名(通过1000轮采样对抗得到)****************

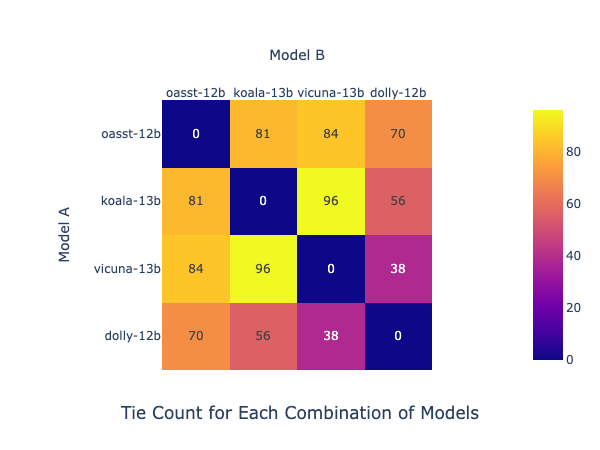

鉴于Likert量表,是否将4或5作为胜利的标准也存在争议,因此我们还计算了在分数为4或5表示平局的情况下的Elo排名。在这种情况下,相对于此更改,模型之间的排名几乎没有变化。下面是每个模型对之间的平局次数(每个模型对之间有327次比较)和新的Elo分数。每个单元格中的数字表示交叉行和列中模型的平局次数。例如,Koala-13B和Vicuna-13B的平局次数最高,为96次,因此它们在性能上可能非常接近。

请注意,通过选择一行来阅读此图,例如oasst-12b,然后水平向右阅读以查看它与每个其他模型的平局次数。

****************有平局的Elo排名(通过1000轮采样对抗得到)****************

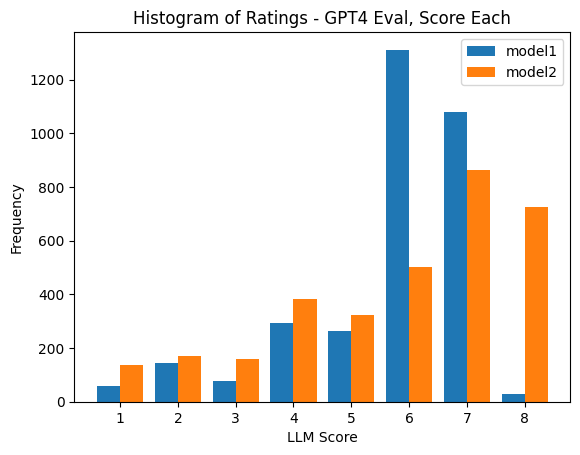

下面是来自Scale AI任务组的评级直方图。

在本文的其余部分,您将看到使用不同的数据生成标准进行类似分析的情况。

GPT-4 Elo结果

接下来,我们转向GPT-4,看看结果如何比较。模型的顺序保持不变,但相对的差距发生了变化。

没有平局的Elo排名(通过1000轮采样对抗得到)

有平局的Elo排名(通过1000轮采样对抗得到)

提醒一下,在Likert量表1到8中,我们将分数4和5定义为平局。

为了做到这一点,我们使用了从FastChat评估提示中改编的提示,鼓励更短的长度以实现更快和更便宜的生成(因为大多数情况下解释是被忽略的):

### 问题

{question}

### Assistant 1的回答开始

{answer_1}

### Assistant 1的回答结束

### Assistant 2的回答开始

{answer_2}

### Assistant 2的回答结束

### 系统

我们希望请您对两个AI助手在上面显示的用户问题的回答性能提供反馈。

请比较它们回答的有用性、相关性、准确性和详细程度。

评分应为1、2、3、4、5、6、7或8的集合,其中较高的数字表示Assistant 2优于Assistant 1。

请首先输出一个仅包含一个值的单行,表示Assistant 1和2之间的偏好。

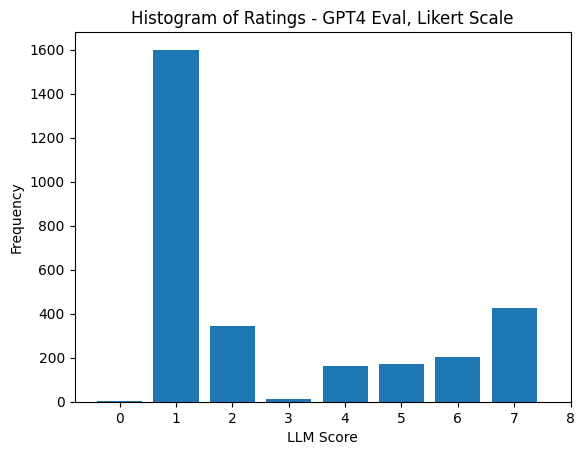

在随后的行中,请提供对您的评估的简要说明,避免任何潜在的偏见,并确保回答的呈现顺序不会影响您的判断。来自GPT-4的响应直方图开始显示LLM评估的一个明显问题:位置偏差。此得分分布是在完全随机的顺序中包括在answer_1中的模型。

考虑到GPT-4评估的不确定性,我们决定向我们的排名中添加另一个基准:由经过高度训练的人完成的补全。我们想要回答的问题是:如果由GPT-4进行评估,人类的Elo排名将是多少。

带演示的GPT-4 Elo结果

最终,人类演示的Elo排名明显令人困惑。有很多假设可以解释这一点,但它指向一个潜在的风格优势,即在与大型语言模型的输出进行训练的模型(与Dolly等进行比较时)也受到了赋予。这可能导致在同时开发的训练和评估方法之间产生了****无意中的兴奋剂****。

Elo排名无平局(从1000轮采样游戏中引导)

相关工作

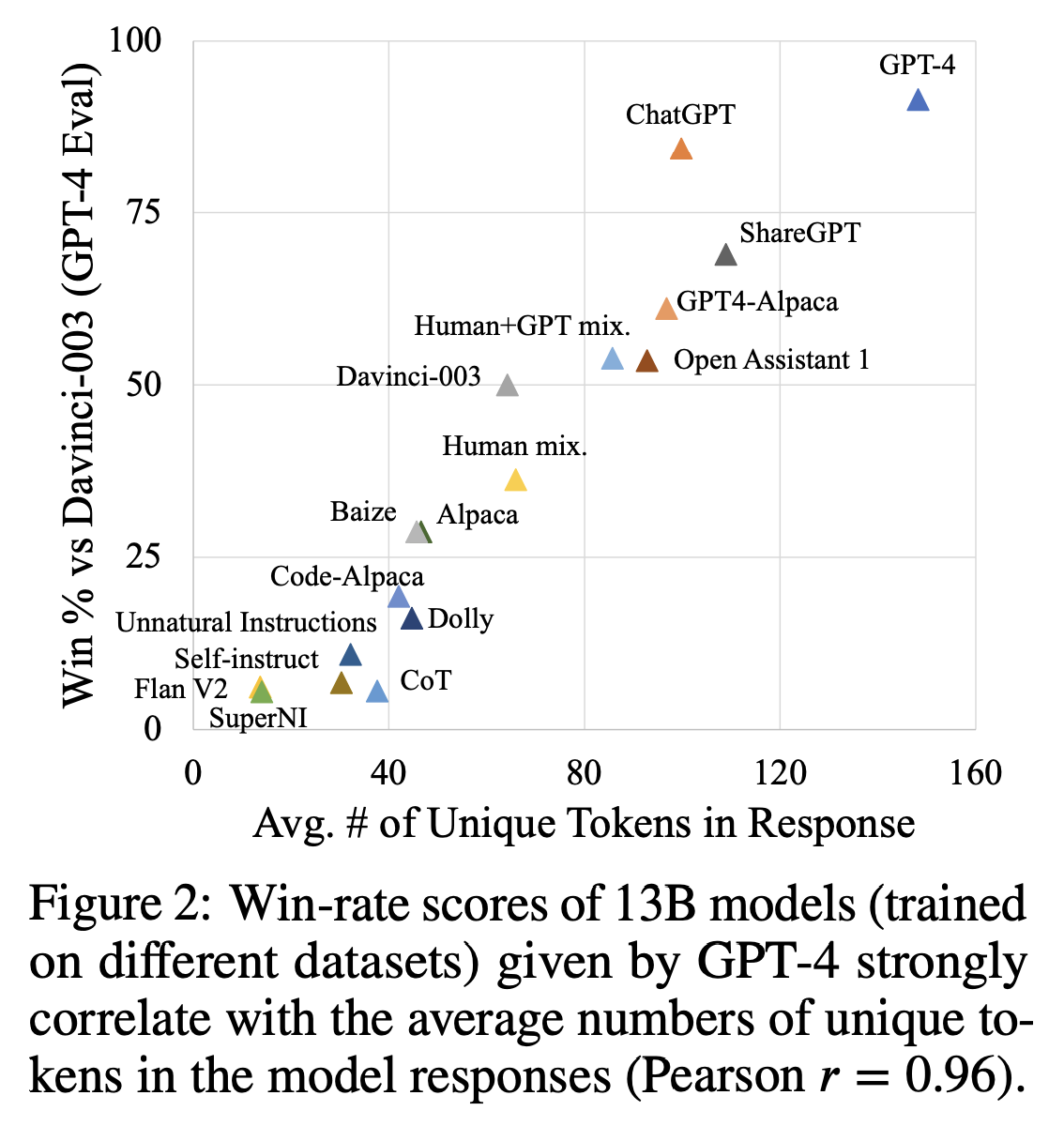

我们不是唯一一个分享GPT-4可能不是用于训练和评估LLM的完美工具的人。最近的两篇论文调查了指令调优对OpenAI模型输出的影响,以及这样做如何影响“模型比较”评估(当您训练模型的输出与ChatGPT或GPT-4的输出进行比较时)。在这方面,Allen AI的论文《骆驼能走多远?》显示了一个可能的指标,说明GPT-4评价一个输出为高分的原因:多样性和回答的长度。这些相关性令人瞩目,因为它奖励模型冗长,即使任务可能不需要。下面是作者将胜率与标记数量相关联的图。

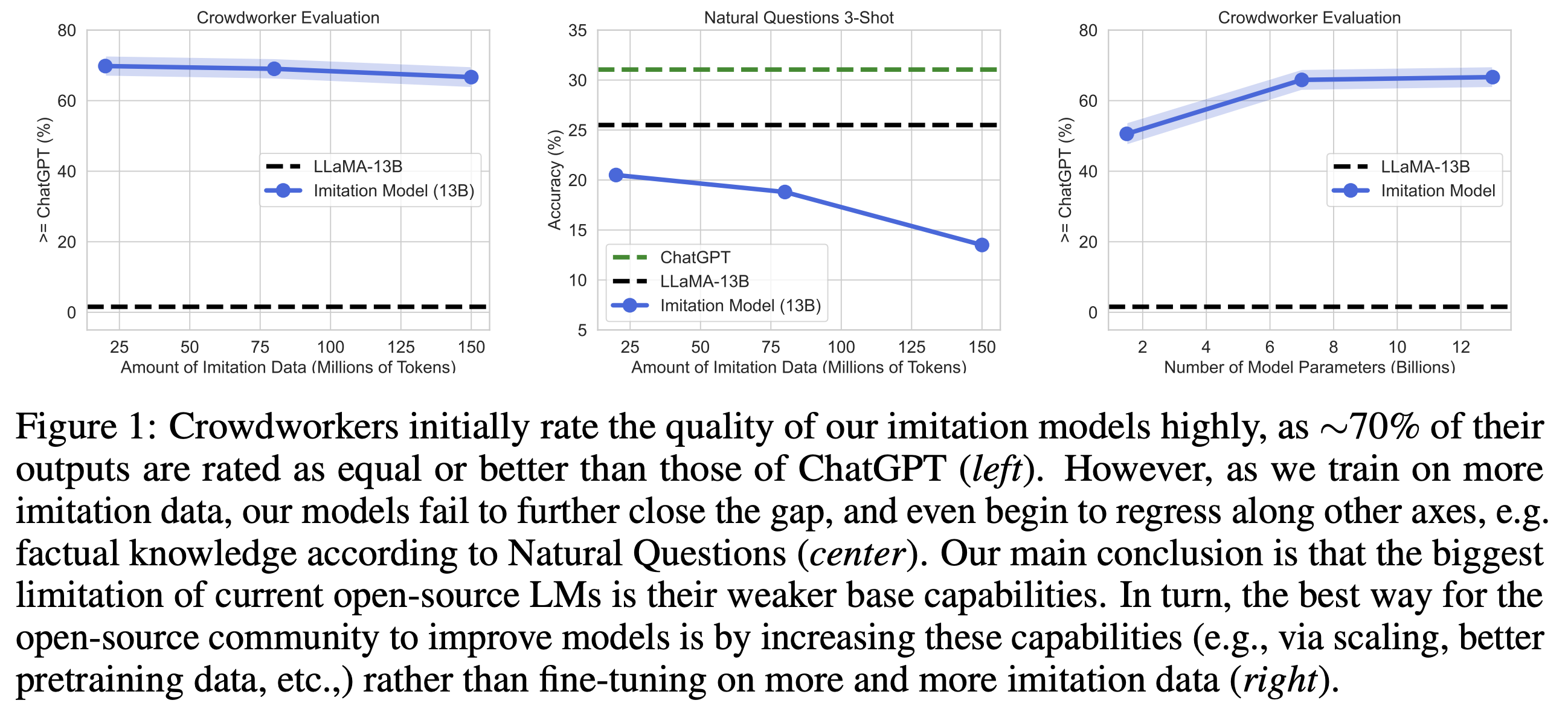

另一篇流行且最近的论文是来自伯克利的《模仿专有LLM的虚假承诺》,作者展示了使用更多数据进行训练实际上会降低比较结果。对于作者所进行的规模,需要进行更多的调查才能完全理解结果,但它指向了一个明确的方向:在训练和评估时,对另一个LLM持谨慎态度。以下是论文中展示这一点的图:

GPT-4评估示例

下面我们包含了一些示例,以便让您了解为什么和如何选择GPT-4:

问题:指出它所属的书籍类型。\n输入:《霍乱时期的爱情》。

模型回答(考拉)::

《霍乱时期的爱情》的类型是一部同时具有魔幻现实主义和历史小说元素的浪漫小说。它讲述了费尔米娜·达扎和弗洛伦蒂诺·阿里萨这两个深深相爱却因各种原因无法在一起的人物。在他们的一生中,他们遇到了阻止他们重新团聚的障碍,包括战争、疾病和社会压力。然而,他们对彼此的爱从未消退,他们继续怀抱着希望,有一天他们将能够再次在一起。浪漫元素和历史背景的结合使这本书属于具有魔幻现实主义和历史虚构元素的浪漫小说类别。

人类回答:

小说

GPT-4评分:1(模型明显更好)

助理1提供了更详细和准确的答案,讨论了浪漫、魔幻现实主义和历史小说在这本小说中的元素。助理2的回答过于简洁,没有提供关于书籍类型的足够信息。

问题:

写一篇LinkedIn帖子宣布您已经接受了一份新工作的邀请。\n输入:

模型回答(考拉)::

令人兴奋的消息!我很高兴地宣布,我已正式接受了一份令人激动的新工作机会,担任[职位名称]在[公司名称]的职位。这个职位将允许我发挥我在[行业/专业领域]的技能和经验,同时也为个人和职业成长提供机会。我想借此机会向在整个招聘过程中支持我的每个人表示感谢,包括[之前的雇主名称或提供指导/建议/推荐的个人]。你们的支持对我来说意义重大,我对你们的帮助感激不尽。

我对未来充满期待,迫不及待地加入[公司名称]的团队。再次感谢你们的支持!

人工回复:

我无法用言语来表达我的激动之情,因为我要与你们分享我接受了XYZ公司市场总监的职位!

如果不是我的朋友[name]与我分享了这个工作机会,以及我的前任老板[boss’s name]对我的出色推荐和指导,我就没有这个机会。

我非常期待开始这段新的旅程,并与我的新家人一起成长——XYZ公司的市场明星们。

GPT-4 评分:6(模型更好)

两个助手都为LinkedIn上发布新工作机会的帖子提供了有用且相关的回复。然而,助手2的回答更加详细,并包括了特定信息的占位符,使用户更容易定制帖子。助手1的回答也很好,但与助手2的回答相比,结构和细节稍显不足。

问题:

给定一个搜索查询和一个文档。判断文档是否与搜索查询相关或不相关。输入:搜索查询:“为什么天空是蓝色” 文档:“简短回答:阳光到达地球的大气层,被空气中的所有气体和颗粒物散射到各个方向。蓝光比其他颜色散射得更多,因为它以更短、更小的波长传播。这就是为什么我们大部分时间看到蓝天的原因。”

模型回复(dolly):

所提供的搜索查询“为什么天空是蓝色”与文档相关,文档解释了天空为什么是蓝色的原因。

优点

这个回答只占用了34个字符,而较长的解释比如太阳光照射到地球上由于其在空间中的速度等等,会占用80个字符。因此,这个回答对许多用户来说非常相关和有用。

缺点

现在,如果问题是关于天气变化的原因,我们可以想到与气候变化、污染、空气中的静电等相关的许多文档,这些文档可能与用户相关,但占用了大量的额外空间,使它们与上述回答相比不太相关。

人工回复:

相关

GPT-4 评分:5(模型稍好)

两个助手都提供了与问题相关的答案,但助手1的答案更详细,解释了天空为什么是蓝色的原因,而助手2的答案简洁但不够详细。助手1的答案对于想要理解这一现象的用户更有帮助,而助手2的答案适合只需要快速确认的用户。

进一步实验

人类和GPT-4标签的相关性

在这里,我们对我们的测试集中的类别进行细分(如前面所列),以显示GPT-4模型在哪些部分可能表现稍好。我们发现,在需要创造力的任务中,分数的相关性要高得多,与事实类别相比。这表明,人类在辨别模型不准确方面做得更好,这是我们所期望的!

消融

使用分数而不是排名的GPT-4 Elo

其他评估基准使用排名系统来比较模型——要求GPT-4返回两个分数并解释其推理过程。我们希望比较这些结果,即使在哲学上它并不适合RLHF训练范式(分数无法训练可靠的偏好模型,而比较可以)。

使用排名显示了提示的位置偏差显著减少,如下所示,以及中位数Elo估计值(不包括并列)。

GPT-4 Elo with asking to de-bias

考虑到我们在Likert评分中观察到的位置偏倚,如果我们在提示中加入去偏倚的要求会怎样呢?我们在评估提示中加入了以下内容:

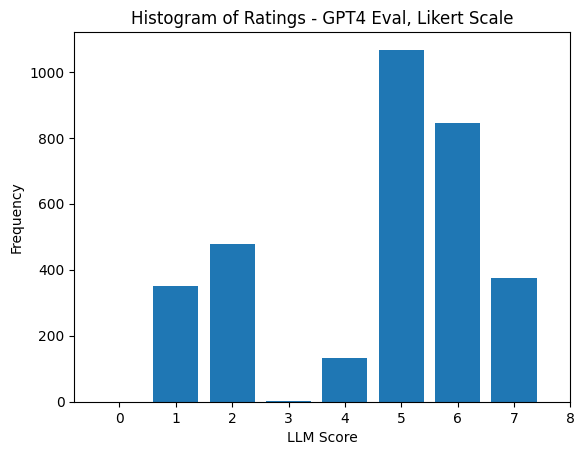

请注意,像您这样的LLM非常容易受到位置偏倚的影响,往往会返回1,请您尽力消除这种偏倚,以使我们的数据公平。这导致了下面的排名直方图,从而翻转了之前的偏倚(但并没有完全解决它)。是的,有时GPT-4会返回超出请求窗口范围(0)的整数。

下面,您可以看到更新后的Likert评级分布和没有平局的Elo估计(这些结果非常接近)。

这是一个实验,在模型添加平局后,模型的排序发生了重大变化:

要点和讨论

这里有很多内容,但我们实验中最重要的见解是:

- GPT-4存在位置偏倚,并且在使用1-8的评分尺度对模型进行配对偏好收集设置时,倾向于生成“1”的评级(1-4代表逐渐减少的模型A,5-8代表逐渐增加的模型B)。

- 要求GPT-4自行去偏倚会使其在另一个方向上出现偏倚,但不像1那样糟糕。

- GPT-4倾向于更喜欢使用InstructGPT/GPT-4/ChatGPT进行数据引导训练的模型,而不是更具事实性和有用性的内容。例如,它更喜欢Vicuna或Alpaca而不是人类编写的输出。

- GPT-4和人类评估者在非编码任务上的相关性为0.5,在编码任务上的相关性较低,但仍然为正相关。

- 如果按任务分组,人类和GPT-4评级之间的相关性在高熵类别(如头脑风暴/生成)中最高,在低熵类别(如编码)中最低。

这个领域的研究非常新颖,因此还有许多领域需要进一步了解:

- Likert vs.评级:在我们的评估中,我们使用Likert量表与RLHF训练模型时收集偏好数据的动机相匹配。在这个设置中,多次重现的结果表明,仅使用分数训练偏好模型不会产生足够的信号(与相对排名相比)。同样,我们认为使用分数进行评估不太可能长期产生有用的信号。

继续这个话题,值得注意的是,ChatGPT(一个性能稍低的模型)实际上甚至无法以正确的格式返回Likert分数的答案,而它在排名方面相对可靠。这暗示了这些模型刚刚开始获得适应我们想要的评估形式的格式控制能力,这一点要远远早于它们成为有用的评估工具。

- 评估提示:在我们的工作中,我们在GPT-4的评估中看到了相当严重的位置偏倚,但还有其他可能影响提示质量的问题。在最近的一期播客中,Riley Goodside描述了LLM对每个标记的信息限制,因此我们目前的提示将分数放在首位可能限制了像GPT-4这样的模型进行全面推理的能力。

- 评分/排名尺度:目前尚不清楚评分或Likert排名的尺度应该是什么样的。LLM在训练集中看到了特定组合(例如1到5颗星),这很可能会对评分的生成产生偏见。与其返回具体的数字,给出特定的标记以返回可能会使结果更加公正。

- 长度偏倚:就像ChatGPT因为生成有趣和详细的答案而受到喜爱一样,我们看到我们与GPT-4的评估严重偏离了简明和正确答案,仅仅是因为另一个模型继续生成更多的标记。

- 正确的生成参数:在我们实验的早期阶段,我们花了很多时间为每个模型获取正确的对话格式(完整版本的示例是FastChat的

conversation.py)。这可能使模型的能力只达到了其最大潜力的70-90%左右。其余的能力将通过调整生成参数(温度、top-p等)来释放出来,但是在没有可靠的评估基准的情况下,今天还没有公平的方法来做到这一点。对于我们的实验,我们使用温度为0.5、top-k为50和top-p为0.95(对于生成,OpenAI的评估需要其他参数)。

资源和引用

- 更多关于我们标注指南的信息,请点击这里。

有一个模型想让 GPT-4 或人工标注员评估吗?在排行榜讨论区给我们留言吧。

@article{rajani2023llm_labels,

author = {Rajani, Nazneen, and Lambert, Nathan and Han, Sheon and Wang, Jean and Nitski, Osvald and Beeching, Edward and Tunstall, Lewis},

title = {基础模型能像人类一样标注数据吗?},

journal = {Hugging Face 博客},

year = {2023},

note = {https://huggingface.co/blog/llm-v-human-data},

}感谢 Joao 指出表格中的一个拼写错误。